本文將介紹當建置NSX的生產或功能驗證環境時,在軟體及硬體方面應該要預先準備的項目,並詳細說明NSX的主要安裝步驟,以及提示各步驟間必須留意的重要細節。

·VMware vRealize Log Insight:如前所述,不是絕對必要,但強烈建議在NSX導入時應該包含的構件。Log Insight負責收集所有NSX Manager/Controller/Edge Server/Host Kernal Module所發出的syslog,進行互動分析,並可看懂NSX Log及製作對應圖表與提供稽核紀錄查詢。在一個VMware SDDC環境內,可以說Log Insight是不可或缺的構件。

·VMware vRealize Operations Manager:同樣不是絕對必要,但也強烈建議在NSX方案內應該導入的構件。不僅僅是vSphere環境,Operations Manager也可以從NSX取得包括網路拓樸、路徑分析、物件狀態、事件記錄的資訊與即時告警等功能。

需求的Infrastructure Services

無論是安裝NSX或是vSphere環境,DNS與NTP的基礎服務都是必要的,必須在建置前確認已有這些服務。此外,依據實際上業務的網路需求,企業可能會部署NSX的網路服務虛擬機器Edge Service Gateway(ESG)來提供實體與邏輯網路介接、南北向防火牆、負載平衡器、VPN等功能。表3內列出ESG需求的容量,於生產環境內企業應該要估算可能需要多少個ESG,如同進行業務虛擬機器的負載估算一般。

表3 NSX-vSphere環境內需求的用戶VM

上面的用戶虛機數量以及需求的Edge Service Gateway/Logical Router Control VM數量決定於實際的用戶環境與架構。企業建置NSX前應該要略做估計,可能會有多少路由器虛機需要被建置,並保留所需要的資源空間。

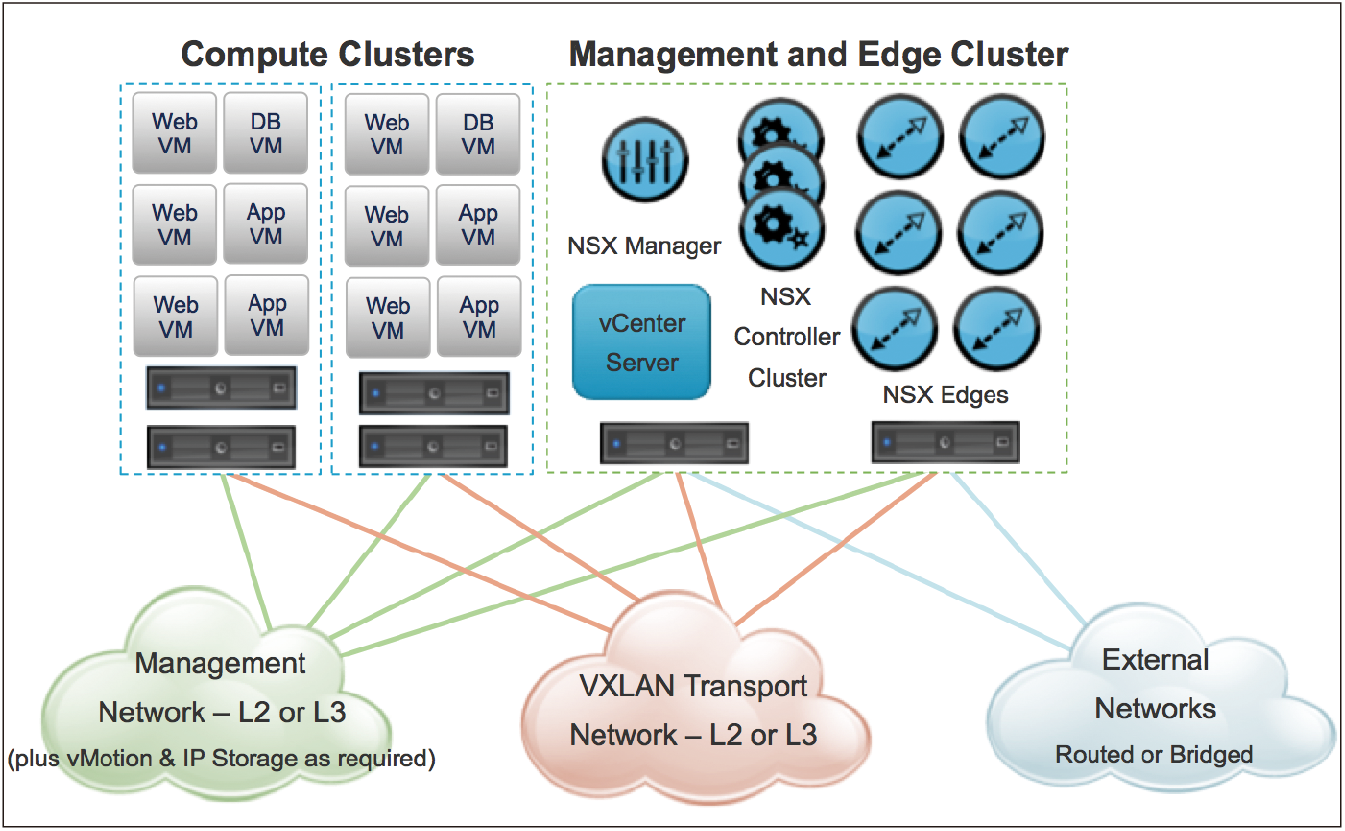

而就一般來說NSX的環境,拓樸大概會長成如圖1所示這樣。要用圖1這張圖與各位展現的重點只有一個:生產環境內,請把放置管理VM的Cluster(Management and Edge Cluster)與用戶VM的伺服器(Compute Cluster)獨立分開。

|

| ▲圖1 NSX環境的拓樸架構。 |

如果目前的環境夠大,請更進一步把管理VM的Cluster與接取實體網路的Edge Cluster也分開。

假設在一個中小型環境內僅能容許有兩組叢集:Management & Edge Cluster和Compute Clusters,那麼對這兩組Cluster內伺服器的要求可以整理成表4所示。

表4 NSX建置環境內的實體伺服器需求

重點三:建立NSX環境時底層網路設備必須有哪些必要功能需求

接下來討論第三個需求:在建立NSX環境時,底層網路設備有哪些必要功能需求,而且有哪些必須進行的組態變更動作呢?在網路虛擬化架構內一個非常重要的效益是所有功能都做在軟體內,所以底層硬體的角色就是提供一個高速而且穩定的轉發骨幹。說真的,我們並不在意底層的網路設備是用A或B或C牌,或是網路架構是三層式、Fabric還是Spine-leaf,但確實,一些基本的網路功能規格是必要的。

因此,這裡列出在底層的網路交換器內我們認為必須要有的功能。只要各位現有或即將要新購資料中心網路設備有符合下列的需求,都是可使用的底層網路設備:

Jumbo Frame

基本上應該所有企業等級的網路交換器都有支援Jumbo Frame,但要強調的是在各台vSphere Host VTEP之間的End-to-End溝通,Jumbo Frame功能一定要打開,且至少為1600 bytes以上。主要的原因在於NSX網路虛擬化功能有採用到VXLAN協定封裝,會在原Ethernet Frame前再加上50個bytes。

VLAN and Trunking

基本上,vSphere Host不管有沒有跑NSX...VLAN與Trunking都是基本需要的功能,相信應該沒有人會用300元一台的交換機來接vSphere Hosts吧!

Cluster or Stacking (optional)

單純就硬體失效考量,各台在機櫃內的vSphere Host裡的網卡應該都要接到至少兩台不同的網路交換器,避免單台交換器失效時整個Host就失聯了。但如果交換器沒有Cluster/Stacking功能,那管理上較複雜,較可能有Spanning Tree產生,L3 Routing介面會有需要設定HSRP/VRRP等機制。若有Clustering/Stacking等機制,把兩台以上堆疊的交換機統一管理,那當然就簡單得多。

LACP/Ether-Channel (optional)

如果需要讓VTEP傳輸VXLAN的Traffic時能同時用到兩條10G網卡或多個1G網卡,使用LACP或Ether-Channel會是很好的考量。但若沒有支援此功能,採用Fail-Over或是用Source-id作Load-balancing等方式仍都可以運作順暢。

L3 Routing (optional)

不是絕對必要,但通常以跑NSX的最佳網路架構設計會盡量扁平化,且L2環境會盡量限制在單一機櫃內,機櫃往核心交換器間會建議跑L3 Routing。因此,通常Top-of-Rack交換器的建議是有支援L3功能為佳。

Backplane Throughput與介面選擇

如前面所說,硬體設備在底層的功用就是提供穩定又高速的骨幹,因此當然Backplane要多大有多大,伺服器能接10G就接10G,往骨幹能走Infinite-band,當然走Infinite-band。那用Gigabit能不能跑?當然可以跑。重點只在跑得快不快而已。如果環境不大,伺服器接1G網卡,往骨幹走多條1G線路,仍然能正常運作。