這裡將以實作演練的方式說明採用最新Windows Server 2019雲端作業系統打造的S2D軟體定義儲存方案,讓大家了解新世代Windows Server 2019雲端作業系統,在SDS軟體定義儲存技術上有哪些新增及增強的功能,而且只要透過Windows Admin Center管理平台更可以輕鬆快速地管理S2D叢集。

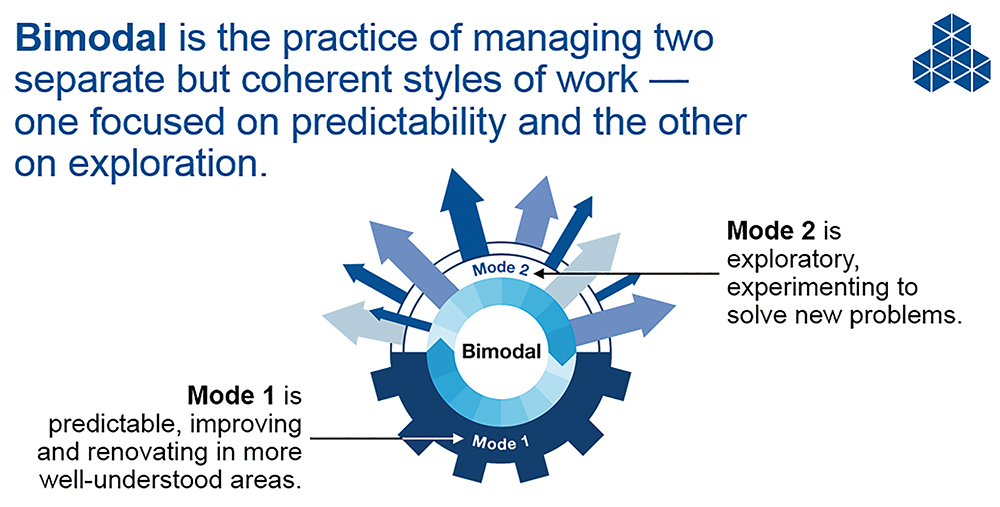

根據Gartner市調機構的研究結果顯示,在2017年時全球大型企業中便已經有高達75%的比例建構名為「Bimodal IT」的雙重IT基礎架構,分別是Mode 1和Mode 2,如圖1所示。

�圖1 Bimodal IT雙重IT基礎架構示意圖。(圖片來源:Gartner官方網站 - What is Bimodal IT? See Gartner's IT Glossary For The Answer)

�圖1 Bimodal IT雙重IT基礎架構示意圖。(圖片來源:Gartner官方網站 - What is Bimodal IT? See Gartner's IT Glossary For The Answer)

簡言之,在傳統Mode 1資料中心內的工作負載、技術架構、執行流程以及部署模式已經行之有年,無須再驗證。然而,新興的Mode 2資料中心與傳統Mode 1資料中心大不相同。

同時,在該份Gartner調查報告中也指出,從2016年開始,便已經有三分之二以上的企業與組織開始建構及整合稱為「基礎架構敏捷化」(Infrastructure Agility)的Mode 2敏捷式IT基礎架構。由Mode 2所建構的資料中心,強調的是「敏捷性」(Agility)與「可擴充性」(Scalability),可以協助企業快速地推出各種服務,以因應不斷快速變化的商業數位化需求。

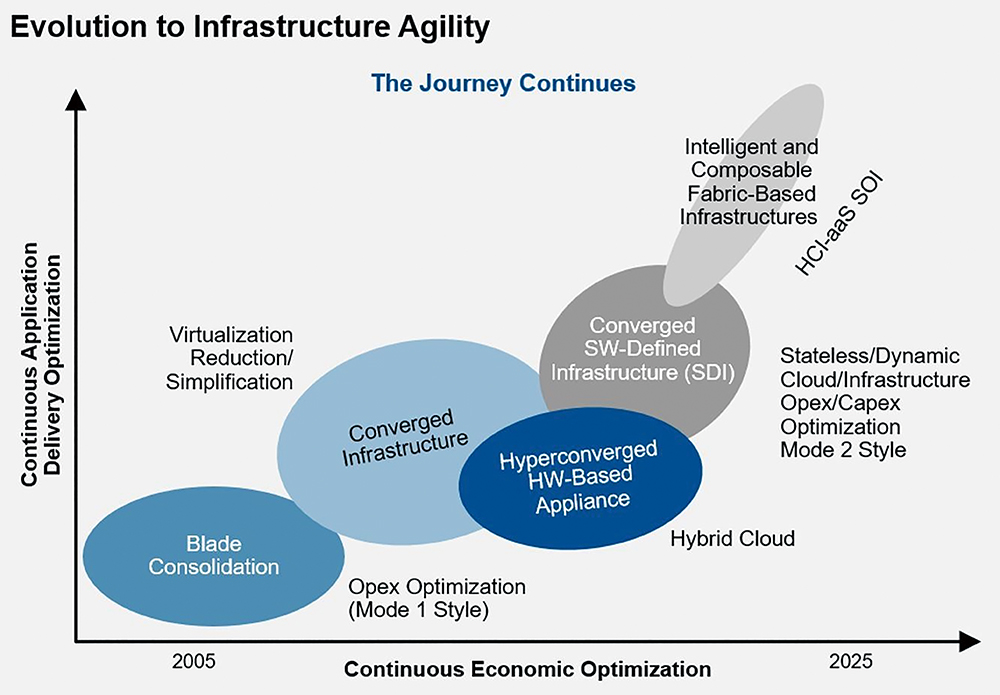

過去,在企業組織中傳統式的Mode1資料中心內,運算資源和儲存資源總是各司其職各自獨立,然而IT管理人員應該不難發現市場上的解決方案,已經從幾年前的「融合式基礎架構」(Converged Infrastructure),演變為新興的「超融合基礎架構」(Hyper-Converged Infrastructure,HCI),便是希望能夠解決傳統式Mode1資料中心內運算與儲存資源整合及擴充方面的困擾,進而打造出高可擴充性且靈活性高的Mode 2基礎架構敏捷化的目標,如圖2所示。

�圖2 基礎架構敏捷化發展歷程。(圖片來源:HPE recognized as a leader by Gartner in new Magic Quadrant for Hyperconverged Infrastructure)

�圖2 基礎架構敏捷化發展歷程。(圖片來源:HPE recognized as a leader by Gartner in new Magic Quadrant for Hyperconverged Infrastructure)

事實上,微軟在2016年10月推出Windows Server 2016作業系統版本時,IT管理人員便可以透過標準的x86硬體伺服器搭配Windows Server 2016內建的S2D(Storage Spaces Direct)機制,手動為企業打造出HCI超融合基礎架構,而無須購買相對昂貴且又有硬體綁定問題的HCI超融合基礎架構解決方案。

隨著微軟在2018年10月推出最新一代Windows Server 2019雲端作業系統,也將原本SDS軟體定義儲存方案的S2D(Storage Spaces Direct)推升至第二世代。本文將說明及實作演練採用最新Windows Server 2019雲端作業系統所打造的S2D軟體定義儲存方案,並指出與前一代Windows Server 2016所打造的S2D軟體定義儲存方案有哪些不同之處。

Windows Server 2019 S2D新增特色功能

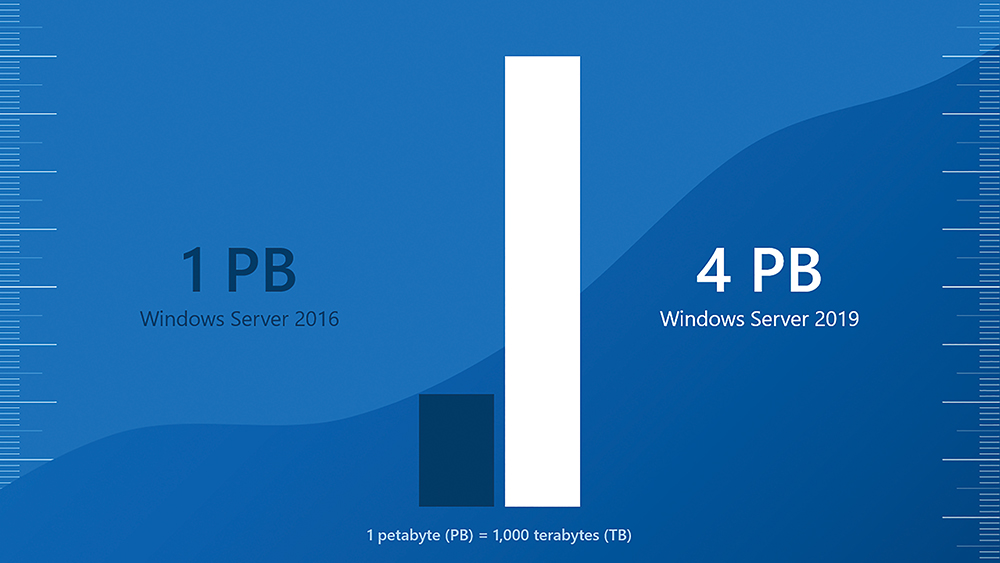

在Windows Server 2019雲端作業系統中,第二世代的S2D軟體定義儲存解決方案,除了新增多項亮眼功能外,原有的特色功能及運作規模和相關支援度也都再度提升。舉例來說,在Windows Server 2016版本所建構的S2D超融合基礎架構,最大儲存空間支援至「1PB」,現在透過Windows Server 2019所打造的S2D超融合基礎架構,最大儲存空間可支援高達至「4PB」。

支援更大的運作規模

隨著硬碟供應商因應大量儲存需求而不斷提升硬碟儲存容量,現在主流的硬碟儲存空間已經來到單顆硬碟14TB的儲存空間。因此,這也是為什麼新一代Windows Server 2019所打造的S2D超融合基礎架構,需要支援更大型運作規模的原因之一。

過去,在Windows Server 2016版本所建構的第一世代S2D超融合基礎架構中,單一S2D叢集最大儲存空間支援上限為「1PB」、每台S2D節點主機儲存空間支援上限為「100TB」、單一Volume儲存空間支援上限為「32TB」。

現在透過Windows Server 2019版本所打造的第二世代S2D超融合基礎架構,單一S2D叢集儲存空間最大可支援至「4PB」、每台S2D節點主機儲存空間支援上限提升至「400TB」、單一Volume儲存空間支援上限提升為「64TB」,如圖3所示。

圖3 Windows Server 2019支援更大型運作規模的S2D超融合基礎架構。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

圖3 Windows Server 2019支援更大型運作規模的S2D超融合基礎架構。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

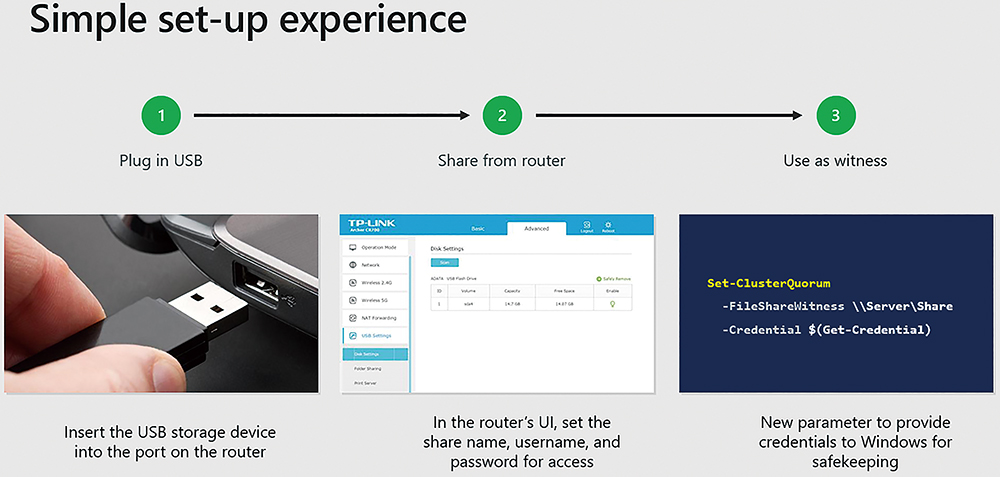

最適用於邊緣運算環境的仲裁機制

事實上,無論IT管理人員採用市面上哪種HCI超融合基礎架構解決方案,都必須搭配「仲裁/見證」(Quorum/Witness)機制,以便因應HCI超融合基礎架構發生災難或故障事件時能夠保持高可用性。過去,在Windows Server 2016版本中,當管理人員建構好S2D超融合基礎架構後,仲裁機制方面僅支援「File Share Witness」和「Cloud Witness」等兩種仲裁機制。

現在新一代Windows Server 2019版本所建構的S2D叢集,已經支援將仲裁機制指向至「USB隨身碟」,如圖4所示。因此,在分支機構或邊緣運算等小型運作環境時,無需其他硬體伺服器、VM虛擬主機、Active Directory、網際網路等等,仍然能夠順利運作S2D叢集並啟用仲裁機制。

�圖4 組態設定Windows Server 2019 USB Witness流程示意圖。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

�圖4 組態設定Windows Server 2019 USB Witness流程示意圖。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

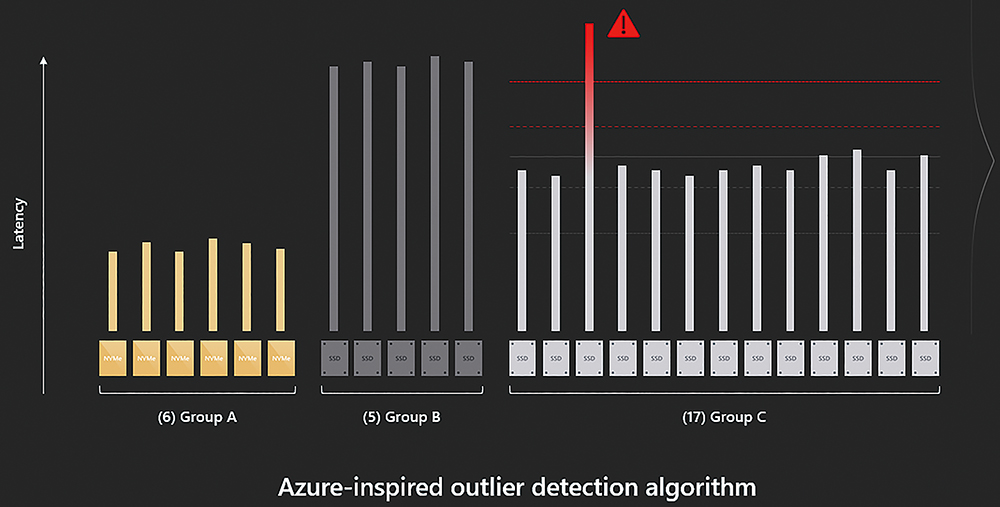

儲存裝置延遲異常檢測機制

在建置S2D超融合基礎架構時,相信管理人員已經採用微軟的最佳建議作法,為每一台S2D叢集節點主機配置相同型號且高效能高耐久性的儲存裝置。然而,即便是企業等級的儲存裝置,也有可能因為儲存裝置中的某個硬體元件不良,或即將損壞而導致效能低落,那麼管理人員如何在S2D叢集內眾多的儲存裝置中找出效能低落的儲存裝置?

在Windows Server 2019 S2D叢集中新增了儲存裝置延遲異常檢測機制,如圖5所示,這項新增機制的靈感來自於Microsoft Azure公有雲環境檢測儲存裝置異常的作法。現在Windows Server將會記錄每個儲存裝置每次資料「讀取/寫入」(Read/Write)的結果以及延遲時間,因此當儲存裝置發生資料讀寫效能低落,甚至是資料讀寫失敗的情況時,管理人員能夠輕鬆透過WAC(Windows Admin Center)管理平台或PowerShell Cmdlet快速找出有問題的儲存裝置。

圖5 儲存裝置延遲異常檢測機制示意圖。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

圖5 儲存裝置延遲異常檢測機制示意圖。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

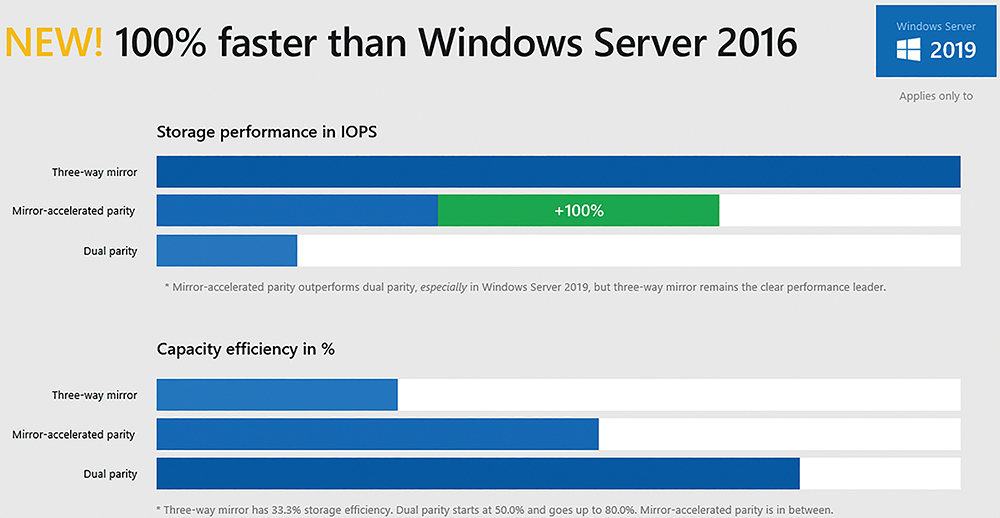

儲存效能加倍的Mirror-Accelerated Parity 事實上,不管採用哪種HCI超融合基礎架構,在「效能」、「儲存空間」以及「資料可用性」這三方面很難同時面面俱到,舉例來說,為了考量資料可用性將資料複寫3份以便因應儲存裝置故障損壞時,仍然能夠保有資料可用性,然而卻也因為資料複寫3份而導致消耗大量的儲存空間。

對此,在S2D叢集中便推出整合RAID-1資料可用性,以及RAID-6節省儲存空間特性的Volume稱之為「Mirror-Accelerated Parity」。簡單來說,在此S2D Volume中,快取層級將會採用效能最佳的3-Way Mirror處理資料讀寫,至於資料儲存層級,則採用能夠節省儲存空間的Dual Parity來處理,讓管理人員可以在運作效能與儲存空間的節省方面取得平衡點。

現在Windows Server 2019 S2D叢集中,針對Mirror-Accelerated Parity儲存效能表現的部分,提供相較於舊版Windows Server 2016 S2D叢集成長1倍,如圖6所示,讓管理人員在享有節省儲存空間的同時,又能享有更好的儲存運作效能。

�圖6 Windows Server 2019 S2D Mirror-Accelerated Parity儲存效能表現示意圖。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

�圖6 Windows Server 2019 S2D Mirror-Accelerated Parity儲存效能表現示意圖。(圖片來源:Storage at Microsoft – Here`s what you missed – Five big announcements for Storage Spaces Direct from the Windows Server Summit)

S2D實戰 – 叢集節點主機硬體需求

當企業或組織的IT管理人員,希望在內部資料中心建置S2D軟體定義儲存技術時,建議可以採用下列硬體規格和基本需求硬體元件:

‧叢集節點主機:在S2D叢集中,最小運作規模必須由「2台」叢集節點主機組成,最大運作規模則支援至「16台」叢集節點主機,並且應採用同一家硬體伺服器製造商及型號。

‧CPU處理器:建議至少採用Intel Nehalem及AMD EPYC,或後續新推出的CPU處理器。

‧硬碟控制器:每台叢集節點主機必須採用SATA Connected或SAS HBA Connected硬碟控制器,不支援採用內建的ACHI Controller硬碟控制器,或是RAID Controller磁碟陣列卡。

‧硬碟數量:採用Hybrid架構時,每台叢集節點主機的快取層至少需要2顆儲存裝置,而資料層則至少需要4顆儲存裝置。若採用All-Flash架構,每台叢集節點主機至少需要4顆儲存裝置。

‧網路卡:每台叢集節點主機,建議採用25GbE網路卡或更高速度,並且應選用支援RDMA特色功能(RoCE、iWARP)的網路卡。

建立S2D網域環境

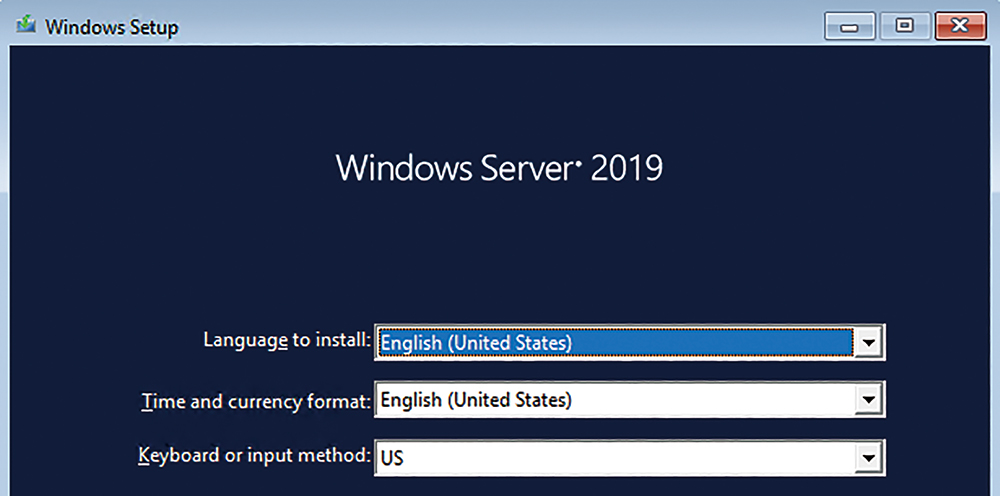

在本文實作環境中,將建立4台Windows Server主機,其中1台擔任Domain Controller網域控制站,另外2台擔任S2D叢集節點主機,最後1台則是安裝及擔任Windows Admin Center管理平台的工作任務,這4台Windows Server主機皆安裝最新Windows Server 2019雲端作業系統,如圖7所示。

�圖7 安裝Windows Server 2019雲端作業系統。

�圖7 安裝Windows Server 2019雲端作業系統。

值得注意的是,當管理人員要將單機環境的Windows Server 2019提升為DC網域控制站時,存放AD資料庫、紀錄檔及SYSVOL分割區必須採用傳統的「NTFS」檔案系統才行,因為AD資料庫並不支援存放於新式的「ReFS」檔案系統。

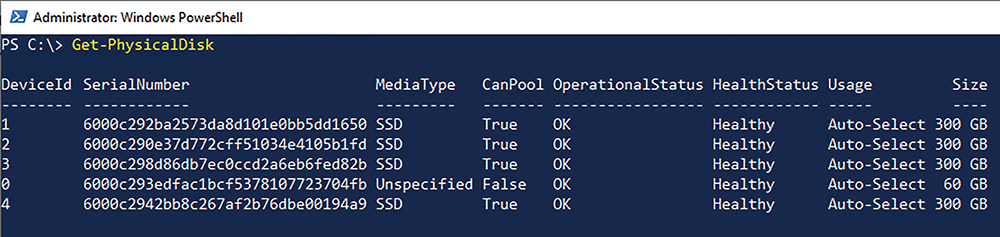

在S2D叢集節點主機的部分,建立2台S2D叢集成員伺服器,並將電腦名稱分別命名為「Node01和「Node02」,每台S2D叢集節點主機除了作業系統硬碟外,皆額外配置「4顆」300GB的SSD固態硬碟,如圖8所示,最後所有的S2D叢集節點主機都必須加入「同一個」Windows AD網域才行。

�圖8 每台S2D叢集節點主機額外配置4顆300GB的SSD固態硬碟。

�圖8 每台S2D叢集節點主機額外配置4顆300GB的SSD固態硬碟。

安裝伺服器角色及功能

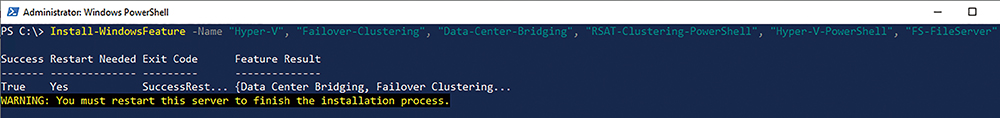

完成S2D網域環境及S2D成員伺服器加入網域的動作後,接著為每台S2D叢集節點主機安裝所需的伺服器角色和功能。

首先開啟PowerShell指令視窗,然後執行「Install-WindowsFeature -Name "Hyper-V", "Failover-Clustering", "Data-Center-Bridging", "RSAT-Clustering-PowerShell", "Hyper-V-PowerShell", "FS-FileServer"」指令(圖9),安裝如下的伺服器角色及功能:

圖9 為每台S2D叢集節點主機安裝所需的伺服器角色及功能。

圖9 為每台S2D叢集節點主機安裝所需的伺服器角色及功能。

‧Hyper-V:安裝Hyper-V伺服器角色,以便S2D叢集節點主機成為Hyper-V虛擬化平台。

‧Failover-Clustering:安裝容錯移轉叢集伺服器功能。

‧Data-Center-Bridging:安裝DCB(Data Center Bridging)伺服器功能,當採用RoCE v2的網路卡時,此伺服器功能為必要安裝選項,倘若採用iWARP網路卡,則可選擇性安裝。

‧RSAT-Clustering-PowerShell:用來安裝用於管理容錯移轉叢集的PowerShell模組。

‧Hyper-V-PowerShell:安裝用於管理Hyper-V虛擬化平台的PowerShell模組。

‧FS-FileServer:安裝檔案伺服器角色,以便後續S2D能夠提供SOFS高可用性檔案伺服器服務。

建立vSwitch虛擬網路交換器

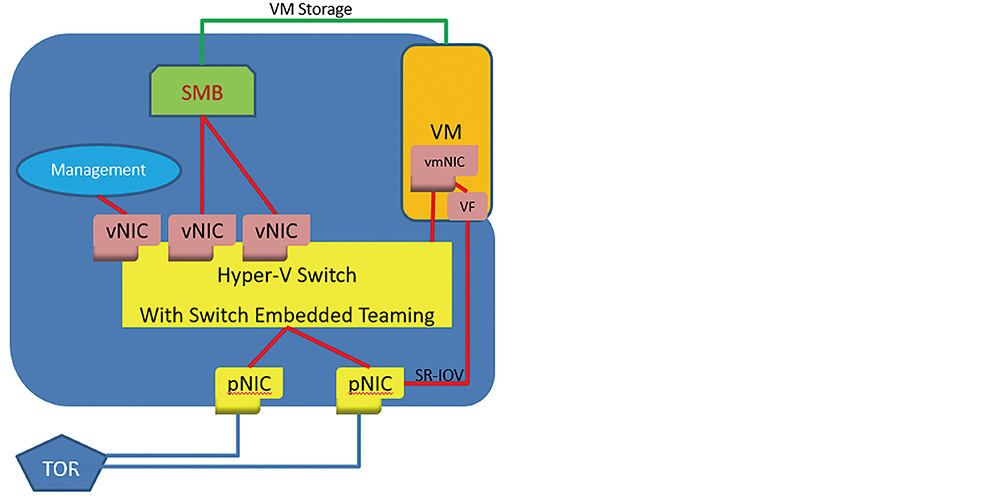

事實上,從Windows Server 2012作業系統版本開始,便已經支援具備RDMA功能的網路卡,但是有一項限制:RDMA網路卡「無法」建立vSwitch虛擬交換器和NIC Teaming,也就是說,RDMA網路卡只能專用於儲存網路而缺少維運管理上的彈性。

雖然這項限制從Windows Server 2016作業系統版本開始便徹底解除,但是在建立Hyper-V vSwitch虛擬網路交換器時,必須採用搭配RDMA網路卡的「SET(Switch-Embedded Teaming)」機制,如圖10所示,而非一般vSwitch虛擬網路交換器。

�圖10 RDMA with Switch-Embedded Teaming運作架構示意圖。(圖片來源:Windows Server 2016 and 2019 RDMA Deployment Guide)

�圖10 RDMA with Switch-Embedded Teaming運作架構示意圖。(圖片來源:Windows Server 2016 and 2019 RDMA Deployment Guide)

此外,目前主流的RDMA通訊協定為RoCE和iWARP,倘若S2D叢集節點主機配置的RDMA網路卡為「RoCE」時,那麼除了S2D叢集節點主機要安裝DCB伺服器功能外,所連接的實體網路交換器也必須支援及啟用DCB功能,並組態設定ETS(Enhanced Transmission Service)和PFC(Priority Flow Control)功能才行。如果S2D叢集節點主機配置的RDMA網路卡是「iWARP」,則無須依賴實體網路交換器的DCB功能及組態設定ETS和PFC功能即可運作。

目前RDMA網路卡中主要支援iWARP協定的供應商為Chelsio及Intel,主要支援RoCE協定的供應商則是Broadcom和Mellanox,甚至Cavium(Marvell)供應商則同時支援iWARP與RoCE協定。

驗證S2D容錯移轉叢集

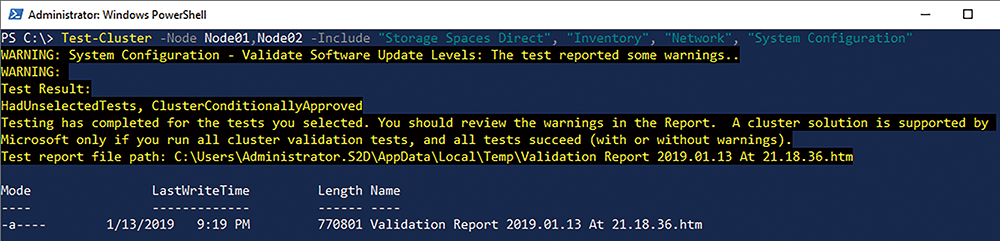

在建立S2D容錯移轉叢集之前,先執行「叢集驗證」(Cluster Validation)的動作,確認目前每台S2D叢集節點主機已經符合各項需求,以避免稍後建立S2D容錯移轉叢集時發生非預期的錯誤。

在本文實作環境中,2台S2D叢集節點主機的電腦名稱為「Node01」和「Node02」,在其中一台主機上開啟PowerShell指令視窗,鍵入「Test-Cluster -Node Node01, Node02 -Include "Storage Spaces Direct", "Inventory", "Network", "System Configuration"」指令,進行叢集環境的驗證動作,如圖11所示。

圖11 驗證S2D叢集節點主機確保符合建立S2D叢集的各項需求。

圖11 驗證S2D叢集節點主機確保符合建立S2D叢集的各項需求。

建立S2D容錯移轉叢集

當S2D叢集節點主機通過容錯移轉叢集驗證程序後,在建立S2D容錯移轉叢集前,必須先確保每台S2D叢集節點主機沒有任何硬碟已經被「宣告」(Claimed)使用,例如硬碟初始化為MBR/GPT、格式化為ReFS檔案系統等等。

若不確認硬碟是否已經初始化或格式化過的話,可以採用Diskpart指令確認硬碟編號,然後使用PowerShell的Clear-Disk指令清除硬碟中所有內容。舉例來說,本文實作環境共有4顆300GB的SSD固態硬碟且編號為1~4,便可以執行「Clear-Disk -Number 1,2,3,4 -RemoveData -RemoveOEM」指令清除硬碟中所有內容。

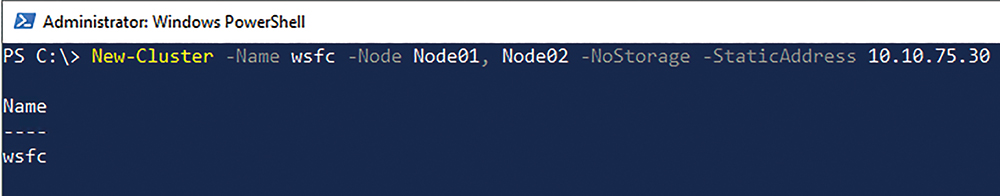

現在管理人員可以放心建立S2D容錯移轉叢集。在本文實作環境中,S2D叢集名稱為「wsfc」,而容錯移轉叢集IP位址為「10.10.75.30」,鍵入「New-Cluster -Name wsfc -Node Node01, Node02 -NoStorage -StaticAddress 10.10.75.30」PowerShell指令建立容錯移轉叢集,如圖12所示。

圖12 建立S2D容錯移轉叢集。

圖12 建立S2D容錯移轉叢集。

啟用Storage Spaces Direct機制

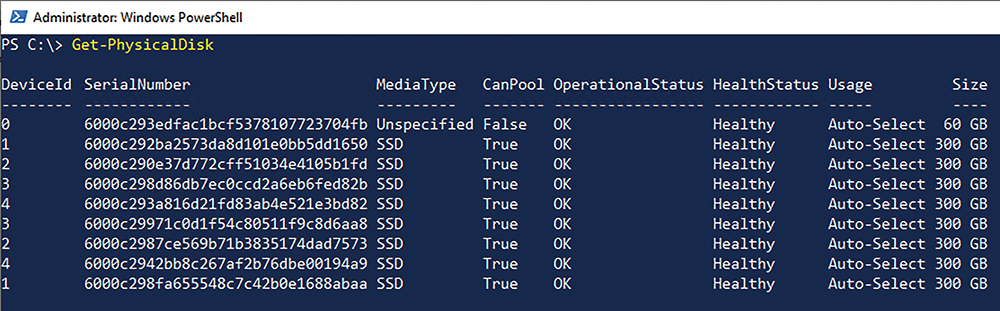

在為S2D叢集啟用Storage Spaces Direct機制之前,再次確認S2D叢集任意一台S2D叢集節點主機,是否可以看到本機硬碟以及S2D叢集中其他叢集節點主機的硬碟數量。例如,本文實作環境中的每台S2D叢集節點主機,除了作業系統外,還額外配置4顆300GB的SSD硬碟,因此任意一台S2D叢集節點主機都應該看到總數「8顆」300GB的SSD硬碟才正確,如圖13所示。

圖13 確認S2D叢集節點主機皆可看到本機及其他台叢集節點主機的硬碟數量。

圖13 確認S2D叢集節點主機皆可看到本機及其他台叢集節點主機的硬碟數量。

確認S2D叢集中總硬碟數量無誤後,便可以在PowerShelld指令視窗中執行「Enable-ClusterStorageSpacesDirect」指令,進行啟用Storage Spaces Direct機制的動作。

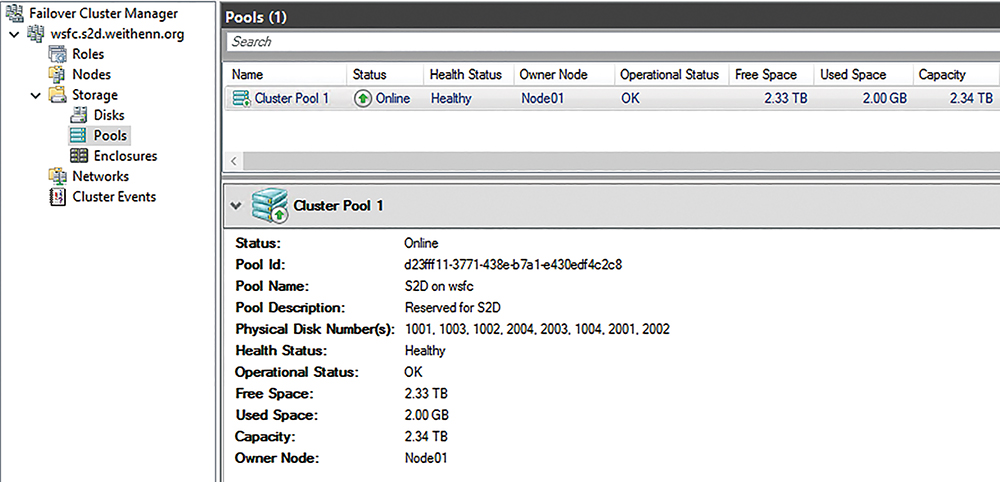

順利為S2D叢集啟用Storage Spaces Direct機制後,管理人員在容錯移轉叢集管理員視窗中依序點選至「Storage > Pools」項目,即可看到目前S2D儲存資源池的空間大小,在實作環境中共採用8顆300GB的SSD固態硬碟,建立後的S2D儲存資源池儲存空間大小便是2.33TB,如圖14所示。

圖14 順利為S2D叢集啟用Storage Spaces Direct機制。

圖14 順利為S2D叢集啟用Storage Spaces Direct機制。

使用WAC管理平台

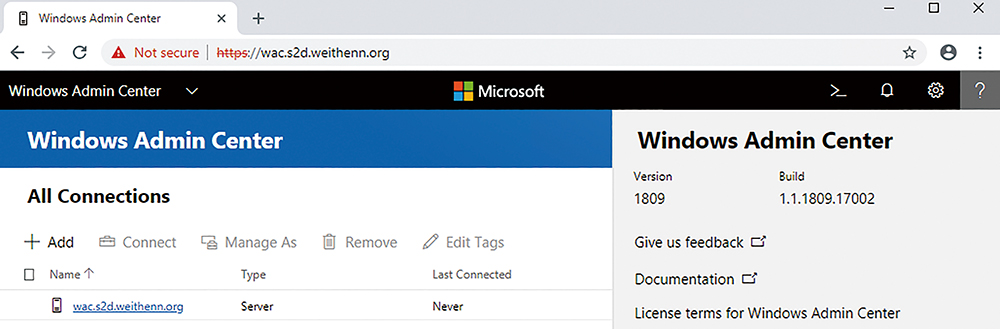

現在管理人員可以透過新世代的WAC管理平台進行S2D超融合基礎架構的管理作業。在本文環境中,安裝最新的Windows Admin Center 1809版本,當安裝程序完畢,管理人員便可採用Microsoft Edge或Google Chrome瀏覽器連接WAC管理平台,並在順利通過使用者身分驗證程序登入後,先看到WAC管理介面簡易的導覽資訊,管理人員可以按下〔Next〕了解導覽資訊,或按下〔Skip Tour〕略過導覽程序,便會立即進入WAC管理介面,如圖15所示。

圖15 採用最新Windows Admin Center 1809版本的WAC管理介面。

圖15 採用最新Windows Admin Center 1809版本的WAC管理介面。

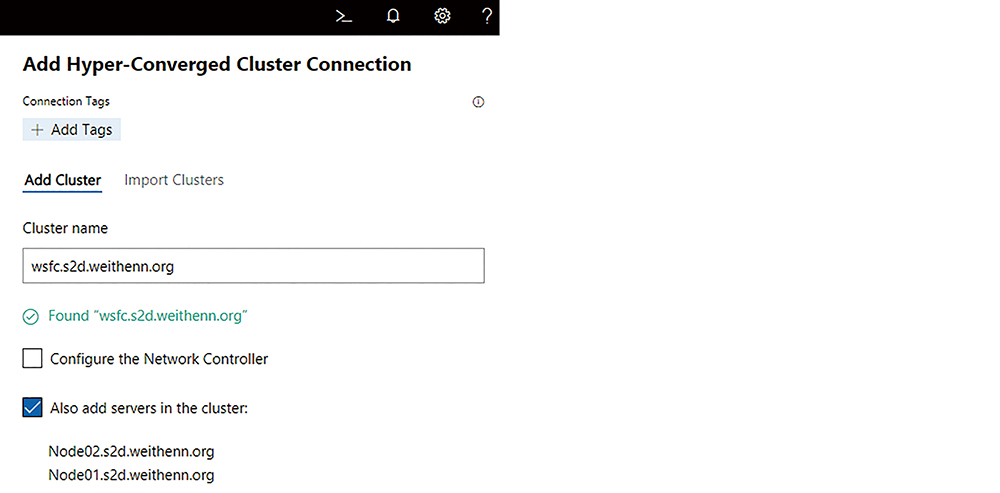

在WAC管理介面中,依序點選「All Connections > Add > Add Hyper-Converged Cluster Connection」項目,然後在「Cluster name」欄位鍵入希望納管的S2D超融合基礎架構叢集名稱,在本文實作環境中名稱為「wsfc.s2d.weithenn.org」,如圖16所示。當WAC管理平台成功納管S2D超融合基礎架構叢集後,將會自動連同所有S2D叢集節點成員主機也一併加入至納管的主機清單中。

圖16 WAC管理平台順利探索到S2D叢集及所有S2D叢集節點成員主機。

圖16 WAC管理平台順利探索到S2D叢集及所有S2D叢集節點成員主機。

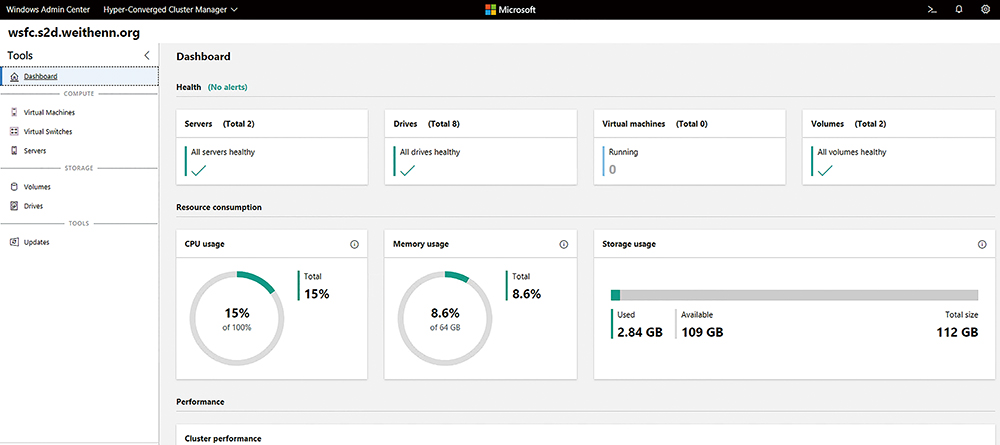

此時,管理人員便會輕鬆看到S2D超融合基礎架構叢集工作負載情況,如圖17所示,包括S2D叢集節點數量、IOPS儲存效能、Latency延遲時間、Throughput傳輸速率、儲存資源剩餘空間、VM虛擬主機運作數量等等。

圖17 透過WAC管理平台管理和查詢S2D超融合基礎架構運作環境。

圖17 透過WAC管理平台管理和查詢S2D超融合基礎架構運作環境。

<本文作者:王偉任,Microsoft MVP及VMware vExpert。早期主要研究Linux/FreeBSD各項整合應用,目前則專注於Microsoft及VMware虛擬化技術及混合雲運作架構,部落格weithenn.org。>