伴隨著半導體技術的演進,處理器發熱功率(TDP)不斷攀升,單顆處理器甚至上看到300至350瓦,如何將熱帶走,已成為伺服器機構設計與資料中心亟待克服的問題。對此,廣運機械於2018年設立熱傳事業部門,開始投入研發,針對資料中心以及高運算伺服器散熱需求推出液冷散熱解決方案。

在自動化生產以及物流系統深耕多年,廣運機械也開始將觸角拓展至新技術領域,近幾年,除了投入第三代半導體碳化矽(SiC)設備、低溫冷鏈物流發貨中心以及海水淡化及污水處理技術之外,全方位散熱解決方案也是投入重點之一。伴隨著半導體技術的演進,處理器發熱功率(TDP)不斷攀升,單顆處理器甚至上看300至350瓦,如何將熱帶走,已成為伺服器機構設計與資料中心亟待克服的問題。對此,廣運機械於2018年設立熱傳事業部門,開始投入研發,針對資料中心以及高運算伺服器散熱需求推出液冷散熱解決方案。

水冷背門本身具有銅管和散熱鰭片,由於穿透背門出來的氣流溫度幾乎等同於由前門吸入的溫度,因此就不需要再區分冷熱通道,簡單地說,就是冷風進、冷風出,如此一來,機櫃的雙邊都是冷通道,資料中心的用電量便可以大幅降低。

水冷背門本身具有銅管和散熱鰭片,由於穿透背門出來的氣流溫度幾乎等同於由前門吸入的溫度,因此就不需要再區分冷熱通道,簡單地說,就是冷風進、冷風出,如此一來,機櫃的雙邊都是冷通道,資料中心的用電量便可以大幅降低。

雙冷通道降低用電量

廣運機械熱傳事業部處長黃癸愿指出,過去為了有效降低能源使用效率(Power Usage Effectiveness,PUE),資料中心經常會運用冷熱通道的手法來加以改善。傳統冷卻空調的設計是讓冷氣由前往後送,當伺服器吸入足夠的冷風後,熱氣便會從後方排走。藉由這個特性,只需要調整機櫃的擺放位置,例如採取背靠背或是前面對前面的作法,讓冷熱空氣分流形成冷熱通道,而後在熱通道的上方設置抽風口讓熱風排出。

藉由雙冷通道,PUE可從1.8降至1.35。

藉由雙冷通道,PUE可從1.8降至1.35。

「但是廣運機械提出新的作法,其主要是運用水冷背門來打造一個雙冷通道,這種方式可讓PUE值達到1.35至1.4之間。」他解釋,水冷背門本身具有銅管和散熱鰭片,當冷空氣由機櫃前門經由伺服器風扇吸入機櫃後,吸入的氣流會帶走伺服器內元件產生的熱能並且往水冷背門方向流動,流經背門的熱風會與熱交換器上的銅管和鰭片相接觸,並且藉由背門內流動的冷卻水產生熱交換,將機櫃內的熱能排出機櫃。由於穿透背門出來的氣流溫度幾乎等同於由前門吸入的溫度,因此就不需要再區分冷熱通道,簡單地說,就是冷風進、冷風出,如此一來,機櫃的雙邊都是冷通道,資料中心的用電量便可以大幅降低。

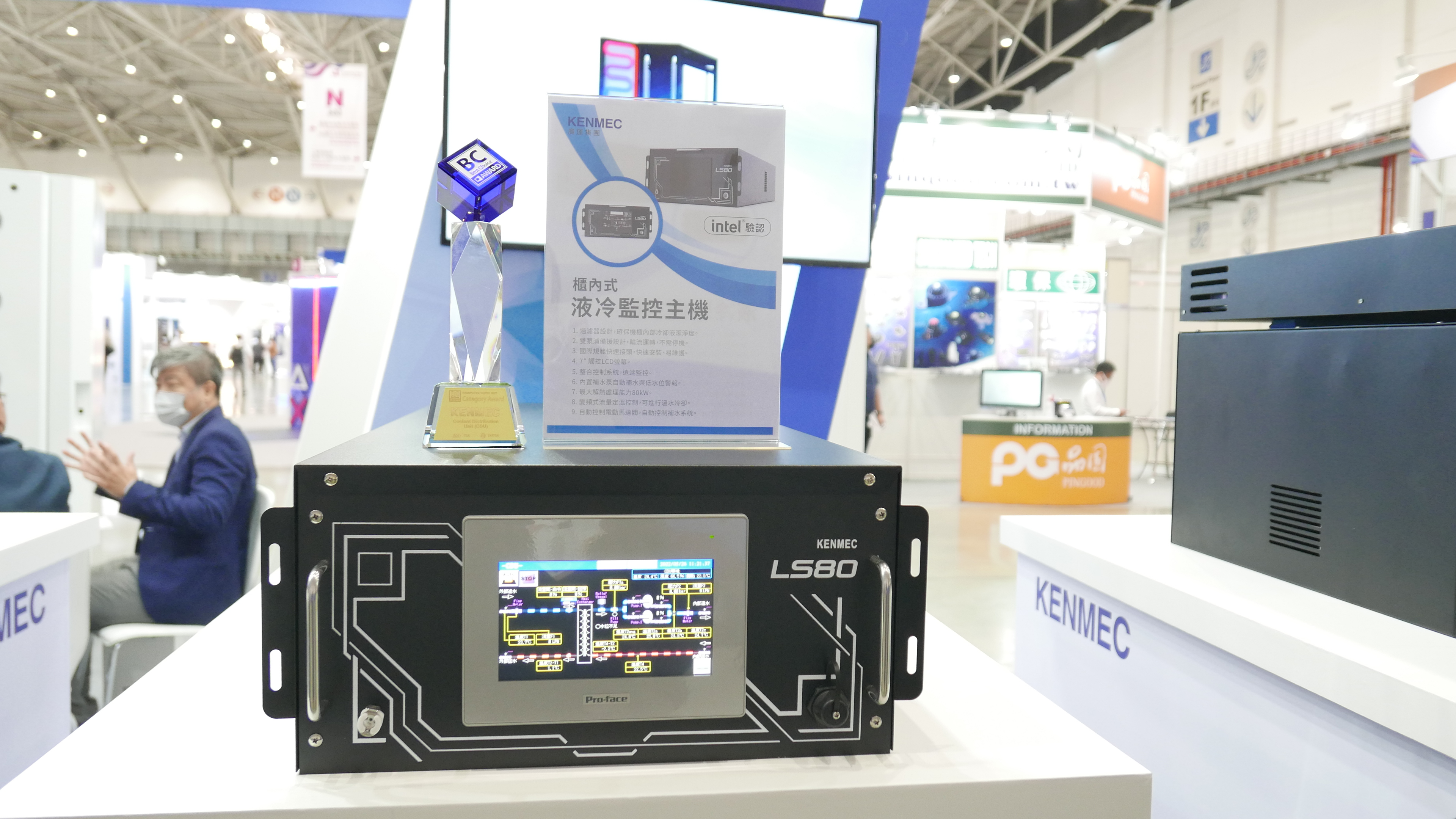

這項液冷方案除了水冷背門之外,還需要搭配液冷監控主機(Cooling Distribution Unit,CDU),其內包含了高效率板式熱交換器、冷卻水雜質過濾器、供水∕回水管路分配器,並且能提供滲漏偵測與異常狀況告警。單一機櫃式CDU可對應數個水冷背門使用,而4U高度的CDU主要是放置在機櫃內使用,其主要功能除了讓背門回水的溫升透過CDU本身的板式熱交換器達到散熱之外,還能對水冷背門進行水流管控以及提供額外的安全警示。

小型液冷監控主機(CDU)已通過Intel認證。

小型液冷監控主機(CDU)已通過Intel認證。

黃癸愿解釋,因為水會產生露點,可能提高伺服器短路的風險,而藉由CDU來監控流量、壓力以及進行露點偵測,透過流量控制來避免露點產生。如果是採取水對水的運作方式,第一迴路的冰水來源為冰水主機,亦即要從冰水主機拉管線接到CDU上,而CDU到水冷背門可視為第二迴路,這個迴路的冷卻水為特殊液體,採封閉式迴路,其添加了微生物抑菌劑、緩蝕劑,同時也會調節液體的酸鹼度到PH7.0中性,如此一來,便可以延長使用期限,不會因為水髒掉而造成堵塞或水流量減少,一般而言,約2~3年汰換一次即可。

但如果是水對氣的運作方式就不需要外部冰水主機,只須搭配CDU以及水冷背門即可。像是針對高效能應用需求的伺服器,由於功耗已漸上看到350W,這時候就可以將水冷頭直接鎖在處理器上,亦即直接在伺服器內走冷卻液,把熱量帶走以避免熱當機。

大型資料中心效益較高

根據國際能源署(IEA)調查指出,全球資料中心用電量約佔全球能源消耗的1%。而大部分的能源需求除了來自於伺服器供電外,冷卻空調的佔比也相當高,根據調查,冷卻空調系統所耗費的能耗約莫佔總體資訊機房用電的三成至四成,如果能夠從製冷系統著手,可節省下來的能源也相當可觀。 廣運機械曾有一實例是協助具有220個機櫃的IT資料中心,從原先的PUE 1.8降至PUE 1.3。該資料中心原先的IT設備功耗為2,690kW,氣冷耗電約2,152kW,改以水冷背門技術後,水冷耗電為807kW。換言之,總用電量下降1,345KW,佔總體用電量27.7%,每年可節省1,178.2萬度電,一年約可減少6,527公噸的二氧化碳排放量。

不過他也提到,雖然此水冷的方案可以協助企業PUE值達到1.4至1.35左右,但是資料中心規模大小對於PUE值的表現會有所影響,主要是因為如果資料中心的耗電量不高的話,即使打造了雙冷通道,可節省下來的電力與成本也有限。「我們最小的CDU為80kW,換言之資料中心至少要80kW才比較划算。而PUE 1.35是以1MW的資料中心計算而來。」黃癸愿提到,這套解決方案在美國已推出一段時間,算是蠻成熟的產品,只是還沒推展到亞洲地區。原因在於,歐美的環保概念比較好,在亞洲推廣就相對辛苦,許多企業只考慮初期投資成本的投入,加以台灣電費相對各國便宜,「但隨著政府開始落實能源轉型與減碳策略,時機點已開始浮現,未來也希望能夠找到系統整合商共同推動,提供給企業一個更好的方案。」