攻擊者的策略變化莫測,攻擊發生的頻率也越來越高,迫使企業必須做好應對任何網路威脅,而這就是機器學習與人工智慧(ML/AI)發揮救援的長處,可提供高效率、可擴充性和卓越的效能預測智慧,為網路威脅偵測和防禦制定重要的優先決策並檢測異常行為。

世界正在以更迅速的方式進行數位轉型與擴張。隨著網路變得更龐大、資料變得複雜,人們已面臨更複雜龐大的網路安全挑戰。現今,網路正走向一個以資料為中心的安全性問題。安全系統處理與分析大量資料,以獲得更多可操控與分析的情報。隨著資料的增加而必須快速收集和儲存更多更複雜的資料。例如,與惡意流量的增長比例相比較,與網路相關的資料量更巨大,需要進行大量分析。

攻擊者的策略變化莫測,攻擊發生的頻率也越來越高,迫使企業必須做好應對任何網路威脅。網路安全人口的供需仍然非常龐大,這使得安全威脅問題益發嚴重。這些都指向網路安全領域不僅僅是透過人工介入,而這就是機器學習與人工智慧(ML/AI)發揮救援的長處。

ML/AI使企業能夠以自動化的方式檢測威脅,進而減少手動處理海量資料的認知辨別責任。ML/AI提供高效率、可擴充性和卓越的效能預測智慧。它還能為網路威脅偵測和防禦用例,制定重要的優先決策並檢測異常行為。

在大規模實施網路優化和執行人工智慧網路安全工作流程,也會遇到一些問題。為了了解和解決網路安全的最佳化和擴展問題,針對DGA(域名生成演算法)檢測模型的一些架構進行了基準測試。在雲端環境中的不同ML/AI框架上運行DGA模型,以分析有效性和可擴展性,並確定資料處理的完成速度。

了解DGA檢測模型

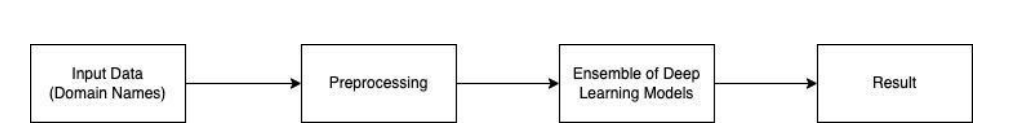

DNS攻擊不斷呈現上升趨勢,攻擊者正在部署網域名稱生成等先進技術,以隨機產生的方式,用於命令和控制(C&C)網域的溝通。 為了偵測DGA攻擊,而提出了一個ML/AI模型,該模型偵測DGA的準確度高達98.63%。在DGA檢測任務中,採用了以往工作中最有潛力的方法,並且使用整合了長短記憶(LSTM)、卷積神經網路(CNN)等各種深度學習性能最好的模型。與其他ML/AI解決方案相比較,它提供了領域的詞彙序列和更好的空間模式檢測,有助於追蹤長期依賴關係(圖1)。

圖1 表示檢測框架的建置組塊

圖1 表示檢測框架的建置組塊

典型的DNS回應時間範圍為20毫秒到120毫秒,執行ML/AI模型需要大量計算。資料中心級DGA偵測框架,可輕鬆與DNS服務器整合,透過低延遲和高流通量處理DNS請求,對資料進行推理操作,以獲得快速可靠的偵測結果。為了優化DGA檢測框架的吞吐量和延遲,必須評估各種ML/AI框架的可擴充性。因此,使用由深度學習模型組成的DGA偵測框架,作為基本場景,以確定在雲端中受支援的哪種ML/AI框架,能夠產生高效的結果。

架構比較

為了達到最佳效能,架構的硬體和軟體元件都需要適合該項目。在硬體方面,圖形處理器有多個核心平行運作,進而能夠協助平行的任務運作得更快,尤其是在批次大量資料處理上。這就是深度學習所執行的核心數學運算,適合使用GPU進行平行運作的原因。人們可以檢查比較中央處理器(CPU)與圖形處理器(GPU)的效能,以分析哪種處理流程最適合任務的要求。

在軟體方面,F5擁有TensorFlow(TF)、OpenNeural Network Exchange(ONNX)和NVIDIA Morpheus等ML程式庫、格式和框架。這次所有ML/AI框架都將使用CPU和GPU運算引擎特定的基礎設施來確定吞吐量和延遲。

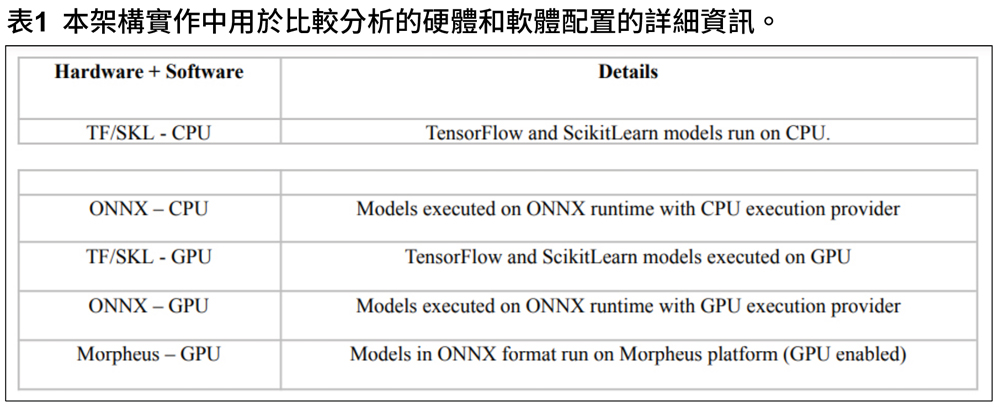

在此次試驗中的測試平台,從各種開源情報(OSINT)來源收集資料並進行預先處理。使用TensorFlow程式庫開發深度學習模型。該架構在GCP的「n1-highmem-8」機器上實現,該機器具有52GB RAM和8個vCPU,GPU使用的是tesla V100。嘗試了多種硬體和軟體配置,如表1所示。

Morpheus流程在延遲和吞吐量方面優於其他配置,詳細配置之間的比較結果將有詳細說明。

實證分析:實驗與結果

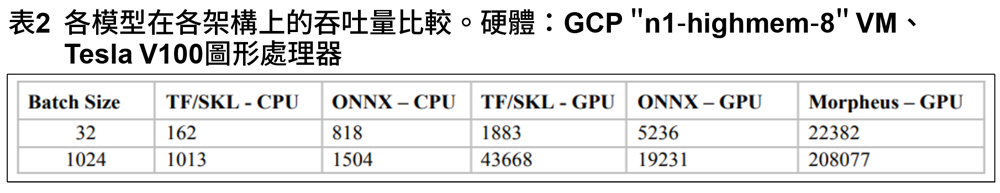

TensorFlow中實作了Astra架構,並在各種架構上執行CPU和GPU。表2顯示了各模型在不同架構上的吞吐量。

首先,使用CPU和GPU對TF/SKL批次大小32和1024的運作進行比較。TF/SKL-CPU配置在批量大小為32吋模型的吞吐量為162個請求/秒,在批量大小為1024吋模型的吞吐量為1013個請求/秒(表2)。當使用GPU運作相同的配置時,在批次大小為32和1024時,吞吐量分別增加11倍(1883個請求/秒)和43倍(43668個請求/秒)。對於在這裡,對於GPU架構,使用cuDNN程式庫來實作LSTM與GPU的平行操作。cuDNN是一個為深層神經網路設計的GPU加速程式庫,可最佳化RNN效能。

第二步,使用ONNX模型架構,這是優化計算最快的模型格式之一。將模型轉換為ONNX格式,並使用CPU和CUDA GPU提供執行運作。CPU執行ONNX批次大小為32(818 req/秒)的效能,是TensorFlow CPU(162 req/秒)的5倍,而批次大小1024的ONNX(1504請求/秒)的效能,是TensorFlow CPU(1013請求/秒)的1.5倍。

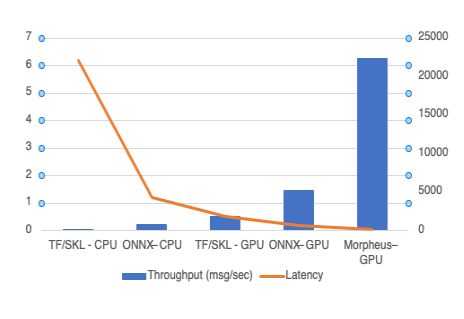

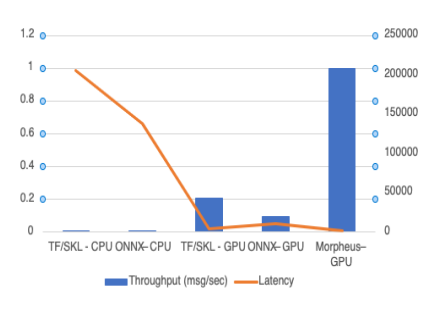

研究發現,執行批次大小為32和1024的ONNX時,具有CUDA GPU執行提供者的ONNX效能,比CPU執行提供者高6倍和13倍。在批次大小為1024時,使用GPU的TensorFlow效能優於使用GPU執行提供者的ONNX。相較之下,在所有其他配置中,後者性能表現更好,因為LSTM的ONNX實作,並未像TensorFlow中的cuDNN LSTM那樣,針對GPU進行最佳優化。圖2和圖3顯示了各種架構上,批次大小32和1024的吞吐量與延遲比較。

最後,比較了不同批次大小的Morpheus-GPU。在這裡,於Morpheus上執行的配置,批次大小為32和1024時,吞吐量達到22382請求/秒和208077請求/秒,分別較先前批次大小為32和1024最佳表現的運作下,分別高出4倍和5倍(圖2、圖3)。Morpheus在NVIDIA GPU加速伺服器上運作。

圖2 各種架構的吞吐量和延遲模型

圖2 各種架構的吞吐量和延遲模型

圖3 不同架構上,批次大小32與批次大小1024的模型吞吐量和延遲。

圖3 不同架構上,批次大小32與批次大小1024的模型吞吐量和延遲。

效能的提升,不僅透過硬體加速,程式設計模型也扮演關鍵的角色。Morpheus可以動態調整資源,並在壓力下將資源重新導向到流程部分。增強、執行非同步運算,以及減輕I/O和GPU阻斷,用基於光纖的編程方法有助於提高流程的性能。 Morpheus-GPU架構在延遲和吞吐量方面,優於所有其他架構。因此,可以利用更大的批次規模,為大型網路提供服務。此外,當與快取一起使用時,這種效能還允許在資料中心級DNS流量上,即時運作DGA檢測模型。

結語

隨著各行業數位化的爆炸性成長,手動瀏覽大量資料已不再可行,對於本已短缺的網路安全人才來說,AI是一個新選擇。人工智慧能夠即時偵測並阻止惡意軟體威脅,進而減輕網路安全專業人員的識別負擔。同時,開發商更需要了解ML工作流程的組成部分,以設計一個最佳化的AI管道,為他們獨特實作用例提供服務。而NVIDIA Morpheus在軟體優化和硬體加速幫助下,為AI人工智慧網路安全方面,提供卓越的推理論速度,實現即時威脅偵測。

<本文作者:F5 資安威脅情資中心該中心將來自合作夥伴的應用程式威脅資料,分析處理成有價的威脅資訊,並與資訊安全社群分享,以協助應對網路威脅。>