本文將示範如何讓VMware vSphere ESXi 5.1來擔任iSCSI Initiator角色,並透過MPIO機制讓多片實體網路卡同時連接iSCSI Target儲存設備,完成這些設定後,平時就會把傳輸流量「負載平衡」到多片網路卡,若發生如網路卡損壞等意外時,也將提供「容錯移轉」功能。

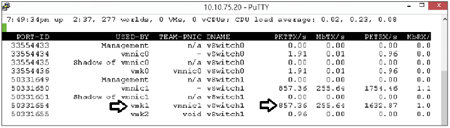

接著,回到SSH Client視窗查看vmnic1,發現已經自動進行容錯移轉機制接手原有的傳輸流量(vmnic2網路卡消失),如圖16所示。

|

| ▲圖16 vmnic1自動進行容錯移轉機制接手流量。 |

測試Round Robin負載平衡機制

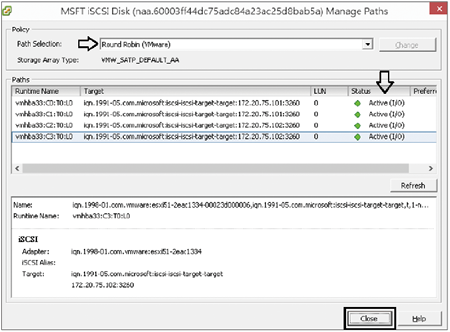

將原先連接vmnic2網路卡上的網路線接回後,由於MPIO機制預設採用的路徑機制為「Fixed」,請於VMware vSphere Client操作介面中依序點選「Configuration > Storage Adapters > vmhba33 > Devices > Manage Paths」,並在Path Selection下拉式選單中選擇【Round Robin】項目,再按下〔Change〕按鈕,即可將MPIO路徑機制改為Round Robin,而每條路徑的狀態列都會變更為「Active(I/O)」,如圖17所示。

|

| ▲圖17 變更MPIO路徑機制為Round Robin。 |

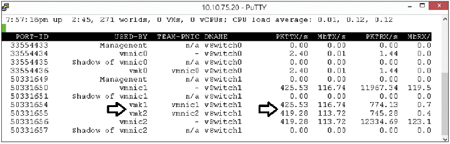

接著,運用同樣的測試方式,可以看到傳輸的流量自動平均分配到vmnic1、vmnic2當中,達成流量負載平衡機制。當然,若有任何一條路徑發生災難斷線,也不會影響到其他條路徑的流量傳輸(圖18)。

|

| ▲圖18 MPIO路徑機制Round Robin流量自動平均分配。 |

結語

iSCSI儲存設備因為具備「資料區塊等級(Block Level)」,並且可以使用乙太網路進行流量傳輸(IP-SAN),因此所建置出來的運作環境與光纖通道(FC-SAN)相比之下,不但低廉許多卻又不失高效穩定的特性。

同時透過MPIO多重路徑機制的幫助,即便是1Gbps的網路運作環境,只要iSCSI儲存設備端與iSCSI Initiator端主機配置具備多個網路卡Port,不但平時可以達成流量負載平衡,當災難發生時也具備容錯移轉機制。更甚者,若採用的是10Gbps的網路環境,還能搭建出不亞於光纖通道的流量傳輸環境。

值得一提的是,一般使用者常常因為VMware vSphere ESXi具備NIC Teaming機制,而會不經意地使用NIC Teaming機制來連結iSCSI Target儲存資源,造成儲存於iSCSI Target上的VM虛擬主機運作不順。這是因為NIC Teaming機制設計為運用於「File Level」類型的儲存設備存取之用(如NAS/NFS),因此拿來存取Block Level的iSCSI Target時,當然就會發生問題或異常現象。

因此讀者只要參考本篇實作,為VMware vSphere ESXi主機設定MPIO多重路徑機制,便可以針對像iSCSI Target這種Block Level設計的儲存設備達到流量最佳化,並且具備負載平衡及容錯移轉的傳輸高可用性機制。

<王偉任,VMware vExpert及Microsoft MVP,網路暱稱Weithenn。由於工作關係經常碰觸不同的作業系統、網路架構、硬體設備、虛擬化技術等,因此希望能將一些技術心得分享給大家,擁有CCNA、NSPA、MCITP、RHCE、VCP等證照,個人網站:http://www.weithenn.org>