生成式人工智慧在近期刮起一股炫風,微軟的Copilot AI讓許多企業的營運流程走向真正智慧化,而新推出的ChatGPT 4也讓人工智慧在推理、文字處理、圖片處理,乃至角色扮演上帶來更高的效益。然而,這樣的大規模平民化也延伸出「數據壟斷」的問題。

生成式人工智慧在近期刮起一股炫風,微軟的Copilot AI讓許多企業的營運流程走向真正智慧化,而新推出的ChatGPT 4也讓人工智慧在推理、文字處理、圖片處理,乃至角色扮演上帶來更高的效益,更讓生成式AI在產業、投資,社會大眾屆更加平民化。

生成式人工智慧帶來技術治理挑戰隱憂

然而,這樣的大規模平民化也延伸出「數據壟斷」的問題,2023年3月25日,微軟發布若競爭對手試圖使用Bing的數據來壯大自己的聊天機器人,公司將切斷數據源,此舉除了威脅主要競爭對手,如Google以外,更可能扼殺新創或中小型業者的生存。

因此,人工智慧如何管理、由誰管理的議題又回到談判桌上,世界經濟論壇倒是提出數大現象,值得政府與企業作為借鑑,例如過去的幾年裡,每個與技術政策相關的組織都提出了一套指導原則,包括Google、IBM和OECD等。根據該組織調查,42%的受訪者認為人工智慧是策略重點,但只有19%的受訪者表示其組織實施負責任的人工智慧計畫,這種差距增加了技術導入失敗的可能性,並迫使公司面臨監管、財務和聲譽風險。

人工技術治理與國際關係掛鉤加鉤大管理複雜度

世界經濟論壇指出,人工智慧是當今推動企業業務增長最關鍵的技術趨勢,截至到2030年,人工智慧預期將為全球GDP帶來15.7兆美元的成長——該數字超過中國和印度目前GDP總和。當然,能力越大,責任越大,人工智慧帶來重大變革同時,風險也隨之而來。 演算法可能會存有偏見或是錯誤的決策,加深人與機器間的不信任,正因對於人工智慧前所未有的發展速度感到危機,許多企業與政府已經開始致力於「負責任的人工智慧」的擬定,這在生成式人工智慧成為產業愛用的技術後更加明顯,許多國家正在思考要如何讓技術推動企業進步同時又避免濫用。

此外,當前國際關係也相當複雜,許多人工智慧的技術存在美中衝突之間,導致被封鎖或是限制的危機,因此這些人工治理技術就容易被升級到國安問題,這是許多企業不熟悉的領域。畢竟過去數十年來是貿易成長的時代,當前的變化是前所未見,讓國家政策與法規制定成為接下來十年要特別留意的議題。

歐盟與美國相繼推出人工智慧規範框架

歐盟可作為技術法規治理的代表,過去提出著名的GDPR政策是針對消費者資料,在人工智慧部分,歐盟也提出相關框架進行規範,歐盟執委會還成立一個人工智慧專案小組,該單位的目的是為負責任和可信賴的人工智慧訂定一個綜合性框架,並提出了人工智慧責任指令。該指令能讓歐盟更利於起訴造成傷害的公司,避免業者開發和部署有害人工智慧演算法,並在特定的應用領域中強化管理,例如警政安防、人員招募,或醫療保健等,由於這些應用層面牽涉到廣大社會大眾生活安全,因此被歐盟列為高度技術治理須管制之領域。

隨著人工智慧使用的增加,未來將看到大量新法規湧入,以解決技術的潛在負面影響,但目前狀況清楚地指出,歐盟人工智慧法案被認為是組織確保合規性之最關鍵的法規,被廣泛認為是全球實施負責任人工智慧的基準。

同時,白宮科技政策辦公室最近發布《人工智慧權利法案藍圖》(Blueprint for an AI Bill of Rights),該法案指出美國政府為防止危害而進行人工智慧治理的願景,隨著這些監管制度的生效,企業將需要改變它們在全球範圍內的營運方式,並在利用人工智慧推動社會進步與保護人類之間取得平衡,該法案涵蓋數個面向,例如建立安全系統、防止演算法的歧視、積極保護個人隱私、說明自動化系統的用途、同時允許使用者安全退出等,說明即便如美國市場自由國家,也開始對技術採用漸進式規範。

事實上,根據IDC針對資訊長的調查指出,歐盟人工智慧法案是他們實施時最關鍵的法規(42%)。其次是英國人工智慧白皮書(37%)和美國隱私保護法(29%)。就政府立場來說,政府應依照技術風險評估高低進行不同程度的監管,而相對上市後才進行監管,上市前、後就監管也較為全面。

人工智慧審計業務是不是一門好生意?

人工智慧如同企業財報一樣,或許會需要第三方機構進行審計(稽核),來確保是否符合法規與企業政策,所謂的人工智慧審計,指的是「確保在人工智慧專案的生命週期內盡量減少或不發生意外,同時讓組織全面明瞭負責任人工智慧的原則,例如團隊在應用程式的設計、實施和維護過程等面向中」。通常在進行相關查核時,世界經濟論壇指出,企業應注意到下述五大面向,以確保技術的可信任程度。

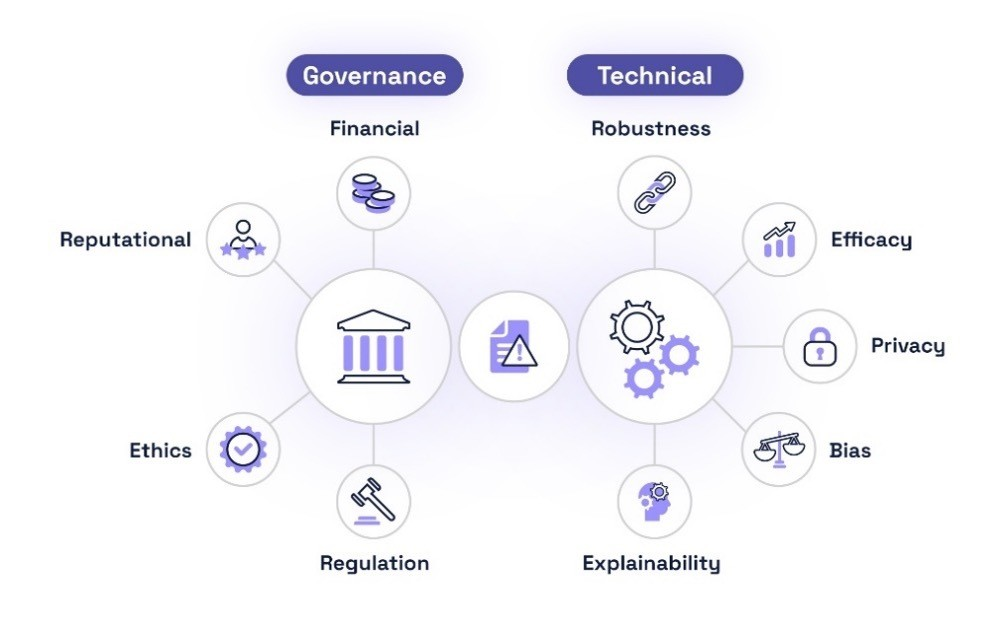

人工智慧技術的管理牽涉到八種不同面向。 (資料來源:Holistic AI)

人工智慧技術的管理牽涉到八種不同面向。 (資料來源:Holistic AI)

1. 功效:系統是否按預期運行並按預期執行。

2. 健壯性或可靠性:系統應該可靠安全,不受到篡改或損害訓練資料的方法。

3. 偏見:系統應避免對個人或群體的不公平對待,導致造成社會衝突。

4. 可解釋性:系統應提供用戶、開發人員和監管機構可以理解的決策或建議。

5. 隱私:系統應按照數據最小化原則進行培訓,並採用增強隱私的技術來減少個人或關鍵資料外洩。

微軟在負責任人工智慧的作法

回歸到微軟,該公司在負責任人工智慧上費不少苦功。

首先,公司在2019年成立專門單位「Aether委員會」(Aether為AI、Ethics and Effects in Engineering and Research的縮寫),該功能團隊任務有二,分別是為技術團隊提供有關如何實現人工智慧治理原則的方針,同時與公司的客戶與社會大眾分享人工智慧知識,做到技術知識透明化。

第二為在2022年6月發布「負責任人工智慧標準」(Responsible AI Standard),微軟透過內建的數位工具來協助識別、衡量和緩解負責任人工智慧的挑戰時,公司將這些工具整合到微軟Azure機器學習開發平台中,同時也導入微軟本身投資的Open AI中。

第三為多元化觀點導入產品與服務中,例如與微軟英國劍橋研究實驗室的團隊、工程師和政策制定者合作,公司認為人工智慧技術在產品設計的決策不能僅是微軟的人,而是需要納入更多利害關係人管理。

<本文作者:Howie Su現為產業分析師>