作者:黃繼寬(新電子/新通訊雜誌主筆)

隨著生成式AI爆紅,PC產業三巨頭英特爾、超微與微軟,都將支援生成式AI作為下一代產品的主要賣點,並希望藉此帶動新一波PC換機潮。

自OpenAI正式發表ChatGPT,為AI技術發展再掀一波新熱潮以來,生成式AI就一直是科技業內的熱門關鍵字。伺服器與高效能運算無疑是生成式AI風潮的第一波受益者,從晶片供應商到伺服器OEM、ODM,都已經享受到生成式AI所帶來的股價跟營收紅利。

但如果從過去AI技術的發展歷程來看,從雲端往邊緣及終端裝置擴散是必然的方向。生成式AI也不例外。畢竟,基於租賃模式的雲端服務雖讓使用者省下了硬體投資跟維護的費用,但生成式AI服務的訂閱費用其實並不便宜,且部分應用場景對本地推論的需求是強制性的,例如用生成式AI來處理涉及營業秘密或敏感商業資訊的文件,就很不容易說服企業採用雲端服務模式。

因此,繼伺服器與高效能運算之後,在PC、工作站等終端裝置上直接進行生成式AI推論,甚至進行微調,打造出更客製化的應用服務,成為必然的發展趨勢。也因為如此,PC產業三巨頭英特爾(Intel)、超微(AMD)與微軟(Microsoft)無不卯足全力,催生出AI PC這個新的產品類別。

綜觀目前英特爾與超微目前針對AI PC所端出的方案,可以發現針對AI PC應用,兩家CPU業者除了將CPU與GPU整合起來之外,又再額外整合了NPU,以進一步實現對AI應用的加速。藉由添加NPU,超微與英特爾最新的AI PC處理器,都可為筆記型電腦提供超過30TOPS的最大運算能力,以滿足未來使用者在筆記型電腦上執行AI應用的需求;某些整合了AI功能的商用套裝軟體,也可因為處理器平台提供的額外硬體加速資源支援而受益。

換言之,依據當下x86處理器業者的產品定義,AI PC跟傳統PC的關鍵差異,在於NPU的有無,而不是PC是否具備AI運算加速的能力。事實上,以NB為例,即便處理器並未內建NPU,也能透過整合式GPU來實現AI運算加速;若是在高階電競NB、桌上型跟工作站這類產品,透過獨立GPU來實現AI加速,更是行之有年的作法。

但內建NPU最大的好處,在於能顯著提高處理器執行AI應用時的能源效率。英特爾在近期舉辦的Core Ultra產品發表會上就指出,以Core Ultra 7 165H跟前一代Core i7 1370P相比,透過NPU加速,165H平台在執行Zoom時,功耗可降低38%;執行INT8測試時,在UL Procyon測試軟件上的能源效率,則可提高2.5倍。能源效率的大幅改善,不僅讓筆記型電腦執行AI運算時,能有更好的電池續航力,同時也對處理器因過熱而降頻運作,造成性能下降的問題,帶來一定程度上的緩解。

因此,AI PC處理器內建NPU的效能,會是處理器廠商之間的重點競爭項目。在這方面,英特爾跟超微所採取的技術路線,就有相當明顯的差異。英特爾處理器平台內建的AI Boost是從Movidius演化而來,可視為專為某些運算任務而特化的處理器;超微Ryzen 9 8000系列中所內建的XDNA 2 NPU,則是從賽靈思(Xilinx)的FPGA架構衍生而來。

超微執行長蘇姿丰(圖1)在日前發表自家新一代AI PC處理器平台時,就很自豪地表示,超微之所以能領先業界,在2023年就將AI PC處理器推向量產,讓PC OEM夥伴能賣出數百萬台AI PC,關鍵就在於其處理器內建的NPU技術根源來自於賽靈思。由於賽靈思的技術已相當成熟並廣獲驗證,因此超微的研發團隊只花了不到一年時間,就能將其整合到自家的處理器產品中。

圖1 超微執行長蘇姿丰表示,XDNA技術源自賽靈思的FPGA,不僅久經驗證,而且具有優秀的擴展性跟適應性。

也因為超微NPU的技術根源來自賽靈思的FPGA,因此超微的NPU具有跟FPGA非常類似的特性跟優勢,例如易於擴展,並且能針對不同運算任務進行調整跟資源分配,具有更好的適應性。事實上,目前的XNDA加速器,可同時為四個AI運算任務進行加速。這也是其他處理器業者的NPU所不具備特殊優勢。

但也因為每家處理器業者所採用的硬體架構不同,加上AI對硬體效能的需求本來就遠高於典型的PC應用軟體,導致軟體開發者有必要針對不同的硬體平台推出對應的最佳化版本。

對軟體開發者而言,如何對不同的硬體平台最佳化,一直都是存在的問題。只是對效能需求較低的應用,最佳化的需求不一定很迫切。但如果對硬體效能需求很高的應用,最佳化的程度就會對使用者體驗造成很大的影響。遊戲軟體就是一個很典型的例子,有些遊戲是針對NVIDIA的GPU做最佳化,有些則是針對超微的GPU做最佳化,這導致同一款遊戲在NVIDIA跟超微的同級顯卡上,往往會有明顯的效能差異。

AI應用也是如此。例如開源生成式AI繪圖軟體Stable Diffusion,目前就有兩種不同的分歧版本,各自針對NVIDIA與超微的GPU最佳化。要在英特爾的Arc GPU上執行Stable Diffusion,則需透過OpenVINO並搭配Hugging Face上針對英特爾最佳化的模型。

因此,對開發社群的支援程度,將是處理器業者在AI領域是否有競爭力的另一個重要關鍵。NVIDIA之所以能在AI領域獨領風騷,靠的不只是GPU的硬體性能,還有一整套對應的開發工具,以及對開發者社群的支援。英特爾跟超微也深知開發工具跟開發社群生態系建購的重要性,並持續進行相關投資,試圖急起直追。

英特爾網路暨邊緣運算事業群平台應用協理王宗業表示,英特爾深知AI應用軟體能否跨硬體平台布署,是AI應用能否真正做到無處不在的關鍵。畢竟,在AI應用從開發到布署的過程中,本來就會使用不同的硬體平台。為協助AI應用開發者更輕鬆地完成跨平台布署,英特爾在幾年前就已推出OpenVINO跟OneAPI,並且將應用支援的範圍從最初的機器視覺,拓展到大語言模型(LLM)跟生成式AI。

在最新的OpenVINO 2023.2版本中,英特爾進一步強化了使用者體驗,並且對LLM及生成式AI提供更完善的支援。在使用者體驗部分,PyTorch模型轉換更容易,並增加Hugging Face生態系統中的可用性和OpenVINO 在C/C++開發者使用的套件管理器。在生成式AI和LLM部分,則是以提升效能為主,例如讓軟體可以調用Core Ultra提供的硬體加速資源,支援INT8模型壓縮、啟用FP16模型格式和整合額外加速庫,來提高LLM的性能和降低延遲。

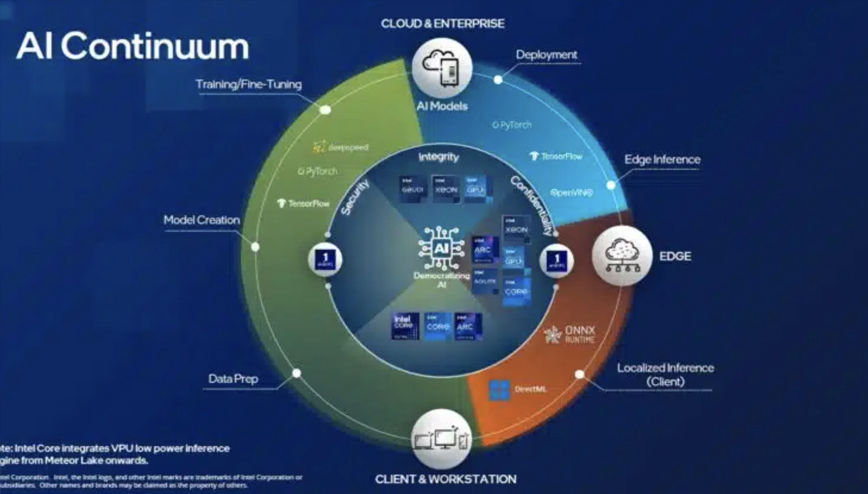

透過這兩項英特爾提供的技術,原本為其他硬體架構撰寫的軟體,只需要少量修改,就能在英特爾的硬體平台上獲得最佳化;反之,原本為英特爾平台撰寫的軟體,也可以布署到安謀(Arm)、蘋果(Apple)的平台上。這就是英特爾近年來一直強調的AI連續性(AI Continuum,圖2)。

圖2 英特爾認為,對AI應用而言,跨硬體平台布署是無可避免的需求。處理器業者必須提供對應工具,協助開發者用更短的時間完成布署作業。

隨著AI應用的類型日益增加,OpenVINO的功能擴充以及開發社群的茁壯,OpenVINO的使用者數量,正在以指數成長。截至目前為止,OpenVINO在Python社群平台上的下載次數,已超過300萬次。

針對AI應用的布署,超微則是推出了Ryzen AI 1.0軟體工具。蘇姿丰表示,日後應用開發者可以從Hugging Face下載已經預先用Pytorch或TensorFlow訓練好的模型,透過Ryzen AI 1.0工具進行量化壓縮,然後在ONNX Runtime上布署。如此一來,搭載Ryzen AI的筆記型電腦就能執行這些AI應用,大幅縮減開發時間。

雖然英特爾跟超微都對AI PC抱有非常高的期待,英特爾甚至喊出2025年AI PC出貨一億台的目標,但最終AI PC能否被市場接受,最重要的關鍵還是在於這類產品能否提供具有吸引力的使用者體驗。

聯寶電腦台北系統開發與認證部研發總監陳基富就指出,雖然處理器業者都將為AI應用打造的NB處理器功耗壓低在典型NB,甚至超薄型NB的功耗水準上,希望能兼顧效能與電池續航力,但從系統整體設計的角度來看,散熱問題要如何解決,還是一個不小的挑戰。因此,聯寶的開發團隊在機構散熱設計方面,越來越依賴由達梭系統(Dassault Systems)提供的模擬技術,藉此加快設計迭代,找到更有效率的散熱解法。

其實,AI NB跟電競NB,在很多地方都有相似之處。如果持續用NB玩遊戲,系統中累積的熱量會導致晶片必須降速運行,影響使用者體驗。同樣的,如果AI NB的使用者一直執行重度AI應用,沒有讓系統有喘息機會的話,累積的熱量也會導致處理器降速,讓AI系統的回應速度變慢。因此,陳基富特別強調散熱設計的強化,對確保AI PC使用者體驗的重要性。

事實上,根據很多AI應用開發者的實測,以及筆者自身在NB上測試Stable Diffusion的經驗都顯示,大約只要連續執行Stable Diffusion超過30分鐘,圖片產生的速度就會慢得非常有感。系統積熱的問題,確實是用NB跑AI,尤其是重度AI的一大挑戰。或許內建NPU的處理器方案可以延後系統因過熱而降速的時間點,但能延後多少,還是需要實測才知道。

因此,如果是對AI功能有重度需求的使用者,以及會長時間使用影音編輯軟體的內容創作者,可能還是要以桌上型電腦或工作站作為主要的生產力工具。2024年上市的AI PC,鎖定的是一般使用情境,例如透過Windows 11的Copilot功能來處理文書、試算表,或是開視訊會議這種短時間或間歇式的使用模式。這類輕度AI應用,跟當下英特爾或超微提供的處理器方案比較契合(圖3)。

圖3 眾多PC品牌業者將推出搭載英特爾新一代Core Ultra處理器的NB產品,但這些產品很明顯是以文書處理、試算表等消費典型商務應用為主。

或許是為了避免模糊焦點,分散行銷力道,當前不管是英特爾或超微,都還不願意透露為桌上型與工作站用戶設計的AI處理器產品發表時程。不過,在發表Core Ultra平台之際,英特爾也在針對入門級伺服器設計的Xeon E產品線推出了內建NPU的新方案,這條產品線有機會向下擴散到工作站市場,只是該產品線的價格定位還是偏高,針對主流工作站設計的Xeon W系列,目前還沒有內建NPU的產品。

有趣的是,在獨立繪圖晶片領域擁有領先優勢的NVIDIA,現階段也不願意針對AI PC議題發表意見,僅低調表示後續會有對應的產品發表。而這個超微、英特爾跟NVIDIA都對桌上型及工作站產品線保持低調的時刻,正好給一家令人意想不到的業者竄出的機會–蘋果。

也因為當下英特爾跟超微所推出的處理器產品,很明顯是以NB應用為主要目標市場,所以第一波AI PC能否成功獲得市場青睞,微軟的Windows 11與Copilot功能將扮演非常重要的角色。

微軟已於自11月正式推出Copilot for Microsoft 365企業版,同時亦發布Microsoft 365 Chat,並在Microsoft Ignite大會上更宣布多項更新,搶攻企業市場的意圖非常明確。Copilot for Microsoft 365 繁體中文版本的釋出細節,也將在近期公布。

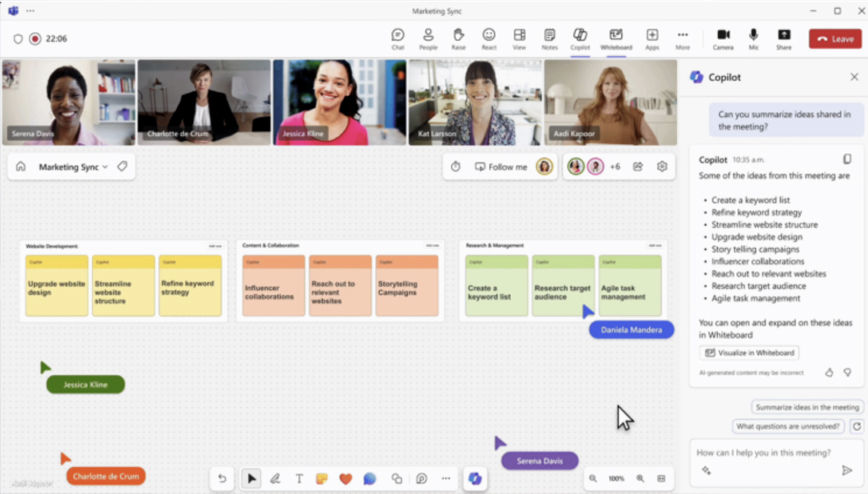

台灣微軟總經理卞志祥表示,歷史上所發生的每個科技拐點突破,都會促動產業快速跳躍並帶來工作與生活方式的巨大轉變;如今 AI 浪潮強勢來襲,特別是在生成式 AI 出現後,大家從討論 AI 能做什麼、到開始關注 AI 該做什麼,企業可藉此翻新思維,思考運用 AI 創造出競爭優勢及突顯差異化價值。AI能協助企業客戶以簡馭繁,藉由智慧生產力工具賦能企業用戶作業體驗升級,以塑造全新的AI工作型態。Copilot的推出,就是為了實現這個願景(圖4)。

圖4 微軟將Copilot技術整合到自家專為企業應用打造的Microsoft 365企業版,希望藉由AI來提高企業員工的生產力。

事實上,讓AI來分擔一部分工作,就能為企業帶來巨大的生產力提升。根據微軟2023年發布的「2023 工作趨勢指數研究報告」統計,在工作環境中,枯燥乏味且重複性高的數位庶務(Digital Debt)工作,會大幅度消耗員工的創新能力;而台灣竟有高達八成的企業員工表示,花費較多時間在進行繁瑣的溝通庶務,包括處理電子郵件與會議等,更欠缺於專注思考與創新發展。該報告也指出,亞太地區78%受訪者表示,他們願意委派工作給AI以減輕工作負擔。因此,在企業市場上,客戶對AI的需求不僅存在,而且非常強烈。

有趣的是,雖然Copilot是採取訂閱制的雲端服務,但微軟認為,用戶端裝置上的AI運算能力也非常重要。把所有的運算任務都交給雲端執行,並非最理想的做法。

微軟Windows與裝置副總裁Pavan Davuluri就指出,Copilot只是微軟將AI與PC連結的門戶,要為使用者提供完整的應用跟使用者體驗,不只需要Copilot,還需要其他技術。在用戶端裝置上內建GPU跟NPU,對許多應用場景來說是必要的。像是為視訊會議應用帶來諸多強化功能的Windows Studio Effects,就需要NPU,而且是效能優異的NPU。

因此,微軟不僅樂見處理器業者將NPU整合進CPU裡,更期待這些NPU的效能持續提升,因為在AI PC的時代,雲端推論與本地端推論是同樣重要的。