人工智慧基礎架構並不只有運算需求,AI資料的儲存、保護以及網路也是非常關鍵。對此,已經有儲存業者開始嗅到商機,不管是如Pure Storage這類全快閃儲存業者或是長期耕耘NAS市場的QNAP都因應企業AI基礎架構的需求,推出集運算與儲存合一的解決方案。

隨著時間與技術演進,人工智慧(Artificial Intelligence,AI)已然愈益成熟,全球許多企業紛紛開始評估、嘗試或導入相關的解決方案,並且結合內部數位轉型的策略,意圖在轉型的過程中,藉由AI開啟商業營運的新篇章。

雖然許多雲端服務供應商已然提供基礎架構資源以及相關的演算法與套件,可以協助企業輕鬆地建構環境,但不少企業更傾向在本地端生產環境建構AI,也因此,如何在企業生產環境中,建置合適的基礎架構也就成為新的議題與挑戰。

最近,NVIDIA推出DGX-2,這是首創可以搭載16張Tesla V100 GPU卡的深度學習運算平台,透過GPU光纖互連技術NVIDIA NVSwitch,能實現以每秒2.4TB的速度同時進行通訊。DGX-2運算效能高達2 petaFLOPS,等同300台伺服器所能提供的處理效能,同時也為企業大幅減少資料中心空間以及冷卻成本。

但是人工智慧基礎架構並不只有運算需求,AI資料的儲存、保護以及網路也是非常關鍵。對此,已經有儲存業者開始嗅到商機,不管是如Pure Storage這類全快閃儲存業者或是長期耕耘NAS市場的QNAP,都因應企業AI基礎架構的需求,推出集運算與儲存合一的解決方案。

AIRI專為分析和AI應用設計

Pure Storage台灣技術總監何與暉指出,Pure Storage之所以攜手NVIDIA,打造AI-Ready Infrastructure(AIRI)的原因,便在於Pure Storage發現客戶在打造AI基礎架構的過程中確實面臨到許多挑戰與難題,希望能夠協助企業用戶更快地進入AI市場,最終整合後的AIRI只有半個機櫃高度,可以讓企業快速部署。

|

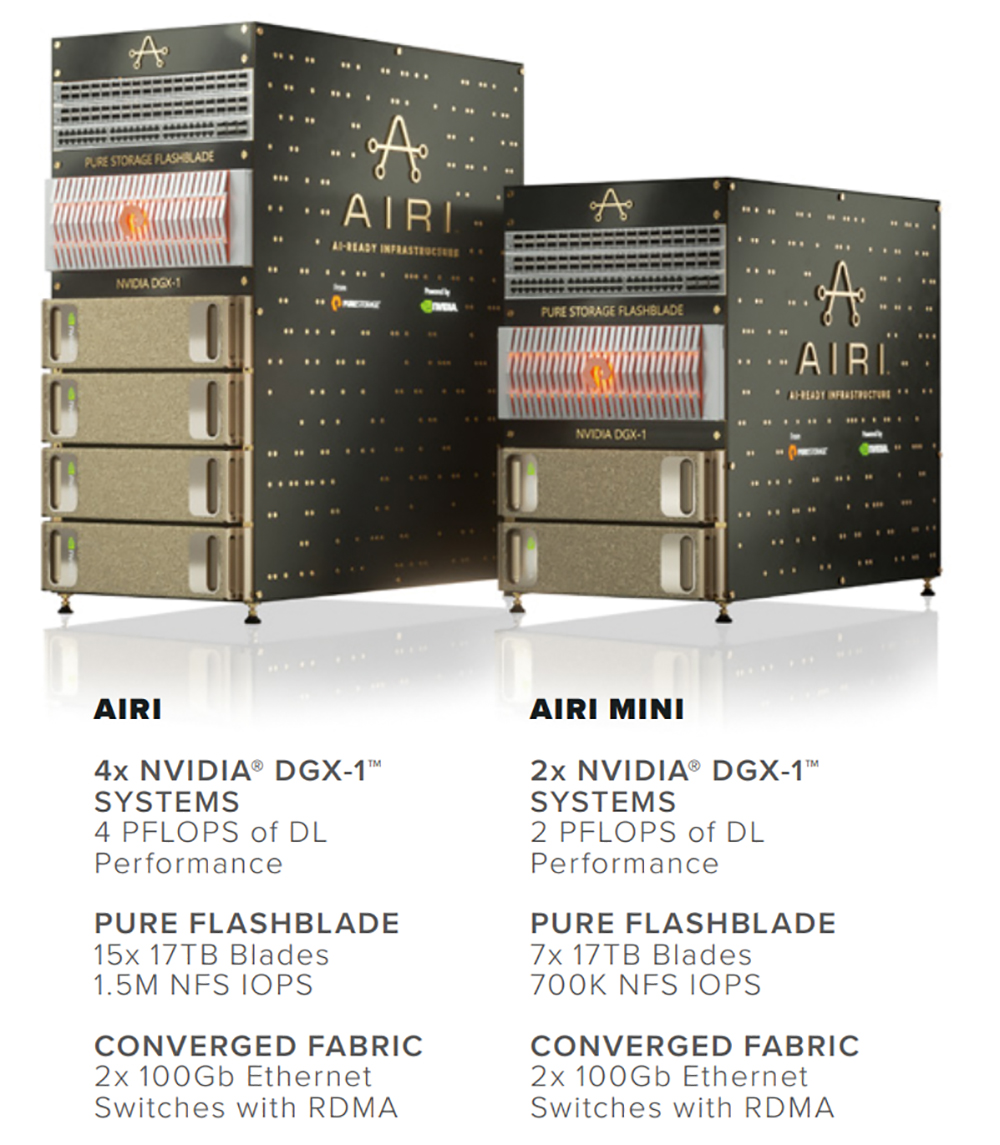

| ▲整合Pure Storage FlashBlade以及NVIDIA DGX-1的AIRI和AIRI Mini,可讓企業快速部署AI基礎架構,資料科學家可以在數小時內就啟動AI計畫,而不用像以往必須等候數週到數個月才能啟動。資料來源:Pure Storage) |

Pure Storage AIRI主要是將Pure Storage既有的FlashBlade刀鋒式全快閃儲存設備,以及四座搭載NVIDIA Tesla V100 GPU的NVIDIA DGX-1進行整合,處理效能高達4 petaFLOPS。除此之外,AIRI還利用Arista 100GbE交換器達成系統互連,以遠端直接記憶體存取(RDMA)的GPU Direct支援以實踐極致的分散式訓練效能。在NVIDIA GPU Cloud深度學習架構及Pure Storage AIRI Scaling Toolkit的支援下,AIRI能夠協助企業在最短數小時內啟動AI專案。

「AI確實能夠增加企業的競爭力,根據瞭解,企業裹足不前的原因,除了資訊安全的擔憂之外,現階段的基礎架構沒有辦法對應到AI需求也是原因之一。」何與暉提到,在行動化、社群媒體、雲端運算以及物聯網的發展下,不只有人類會產生資料,機器也會產生資料,這些資料量愈來愈龐大,如何在短時間內將大量的資料放入設備,就需要快閃儲存的協助,「AI並不是裝備的競賽,但卻需要用裝備來節省時間。因為唯有在更短的時間內得到結果,才有比競爭對手更多一分成功的可能。

他強調四座NVIDIA DGX-1的效能等同40櫃x86伺服器的效能,而FlashBlade則能提供150萬IOPS,過去這需要多達10櫃的磁碟陣列才能辦到。換句話說,在不到20U的空間裡,AIRI提供的是原本50座機櫃才能達到的效能。

針對預算較低或運算力需求較少的企業用戶,Pure Storage也推出AIRI Mini來因應,同樣是將FlashBlade刀鋒式全快閃儲存設備與NVIDIA DGX-1進行整合,差別在於AIRI Mini的運算力及IOPS都是AIRI的一半,亦即AIRI Mini只有2座NVIDIA DGX-1,而FlashBlade的IOPS可到70萬,讓企業以更經濟實惠的預算導入AI基礎架構。

QuAI平台擴展NAS應用

同樣是從儲存領域切入到AI市場,威聯通(QNAP)的策略是在NAS產品中支援GPU卡,以提供運算能力,同時透過「QuAI」人工智慧軟體開發平台來協助企業更快地實現AI應用。如此一來,NAS不只是儲存資料的設備,還能用來建立AI模型、進行推論、預測與分析結果,不斷學習與強化。

威聯通系統解決方案事業處/雲端應用部專案經理張瑞德指出,AI在這幾年的發展很快,從生活、醫療、交通乃至於城市,幾乎各個領域都在運用AI,重點是不需要再為每一種特定的行為事先定義撰寫程式,平台就可以自我學習。以深度學習為例,2010年,卷積神經網路(Convolutional Neural Network,CNN)用於影像與圖形辨識的錯誤率還有30%以上,但到了2015年,辨識率已經比人類還要來得準確,而這也是深度學習受到眾多關注的原因之一。

|

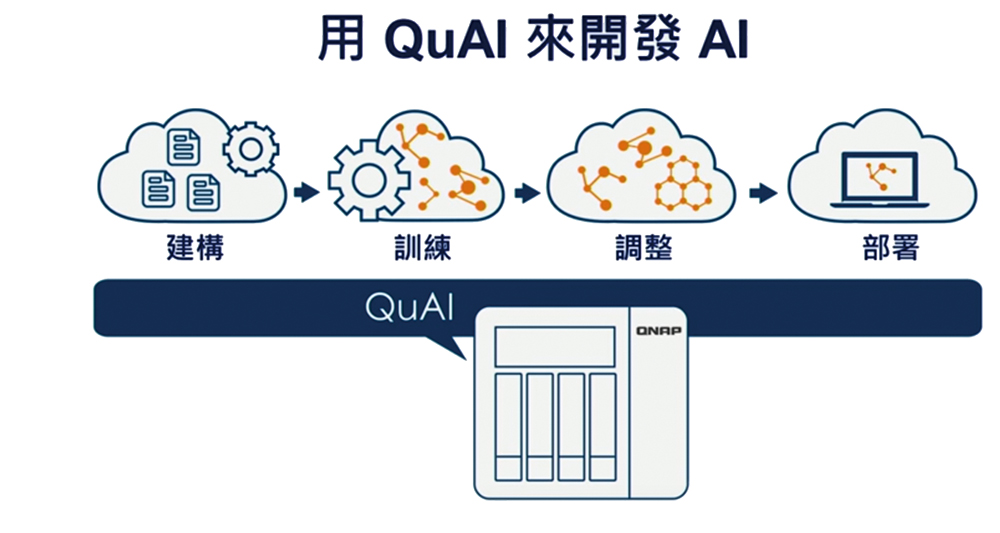

| ▲為了協助企業落地AI應用,QNAP也提供QuAI人工智慧軟體開發平台來簡化複雜度。(資料來源:QNAP) |

「企業現今面臨的問題是,企業聘請了資料科學家,對訓練模型很在行,但是卻不見得對設備熟悉,也不懂得驅動程式、虛擬化以及容器等等。而且還會面臨更多的資料保護問題,因為資料量不是只有GB層級,而是數TB甚至是數十TB,這麼龐大的資料量,光是要備份就會面臨極大的挑戰。」他提到,在QNAP的NAS系統上實踐AI的好處在於,QNAP已經把傳輸、備份、快照、重複資料刪除以及快取功能都已經準備好,過往企業可能要自己拼湊AI基礎架構,需要多台設備才能滿足,如今只要簡化到只剩一台NAS,再加上深度學習的加速卡,就可以同時保有運算以及儲存的功能。

張瑞德坦承,確實很少聽到用NAS來訓練模型,企業常用的方案不是運用雲端上的資源,要不就是買台工作站,但是根據經驗,AI在訓練的過程中最好離資料愈近愈好,因為資料搬移其實是非常大的痛點。「許多資料科學家經常要複製資料,再刪取其中某些少量的資料來進行不同的訓練,試想數千萬張的照片,複製再搬遷其實需要花費很長的時間,若是能直接在手邊的NAS上取得資料,就能大幅提升時間效益。」

為了協助企業落地AI應用,QNAP也提供QuAI人工智慧軟體開發平台,來簡化複雜度,由於QTS 4.3.4版本開始支援GPU卡,並且整合到軟體容器工作站(Container Station)中,因此容器環境也能運用到GPU的資源,大幅添加運算能力,讓人工智慧模型的訓練和推論效能大幅提升。另一方面,QNAP也支援主流的深度學習框架及函式庫,包含Caffe、MXNet、CNTK或是TensorFlow等等,不管企業選擇那一種學習框架,在容器內都可以使用到GPU來加速運算。