軟體定義的儲存(SDS)突破傳統儲存架構困境,將儲存走向開放、統合的境界,讓儲存也能擁有伺服器虛擬化對運算所帶來的簡化、效率及節省成本。近年不少大廠紛紛推出自有解決方案搶攻市場,EMC也不遑多讓推出ViPR、Isilon、ECS以及ScaleIO,本文將分享ScaleIO架構與實際部署經驗。

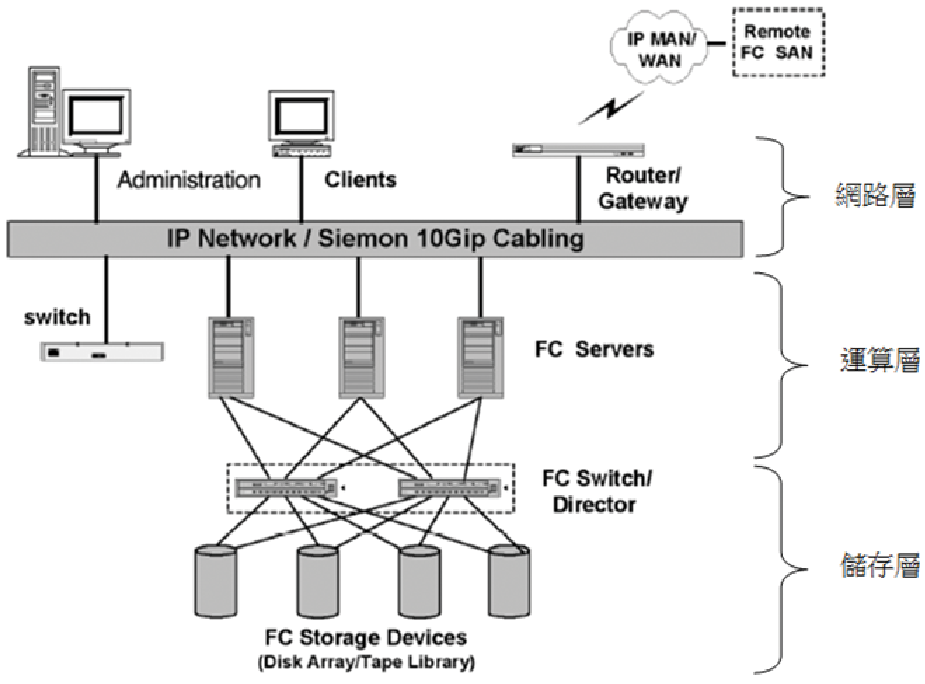

在一般企業基礎建設中,儲存區域網路(Storage Area Network,SAN)包含網路層(Networking Layer)、運算層(Computing Layer)、儲存層(Storage Layer)三層。

伺服器會透過SAN架構(圖1)存取共享空間,但是SDS破除整個框架,可以在單一節點(Node)中同時提供運算及儲存能力,也意謂著傳統三層結構精減成一層。

|

| ▲圖1 傳統SAN架構圖。(圖片來源:siemon.com.uk white_papers) |

ScaleIO功能簡介

以下介紹ScaleIO的Convergence、Scalability、Self-healing、Elasticity以及Performance等多項功能。

Convergence(Converged storage and compute)

現今虛擬技術已成為各企業主流,傳統SAN架構複雜且成本高,ScaleIO能夠化繁為簡,支援Hyper-converged架構,相容於現有Bare-metal(Linux/Windows)、Virtual(ESX、XEN、KVM、Hyper-V),同時兼具運算及儲存能力,大幅減少環境管理及營運成本。

Scalability(Scale up to thousands of servers)

橫向擴充(Scale Out)是SDS的精隨所在,可以因應系統計算規模隨需求擴增。也因為ScaleIO支援1,000個以上的節點,更加符合Hyperscale等級,又具備無縫擴增的計算能力。

反觀VMware VSAN,上限64 Node僅適用於Enterprise以下的部署。ScaleIO效能是可預期的線性成長,當所在環境有新的需求時,可以換算負載並增加相同規格的Server來承受新負載。

Self-healing(Rebuild & Rebalance)

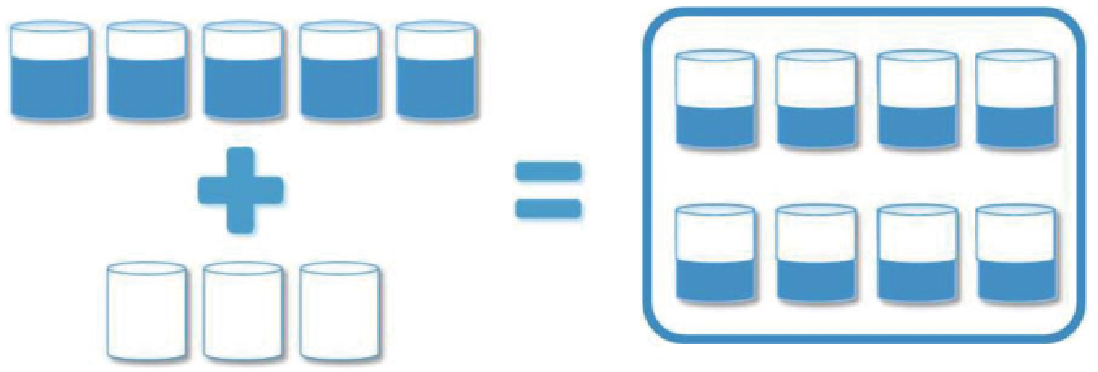

強大的自主能力(Self-healing)透過Rebuild、Rebalance達到系統高可用性及安全性。當ScaleIO擴充Node數量,抑或硬碟增加(圖2),Rebalance就會啟動,系統會分散所有的資料,使每個儲存單元都是平均存量。

|

| ▲圖2 Rebalance達成資料分散。(圖片來源:EMC) |

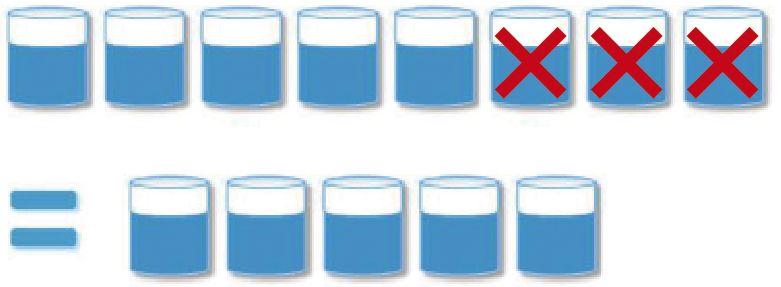

如果是節點變少呢?反之亦然,也會做平均的動作讓儲存量一致(圖3),依照筆者的經驗通常在1%?2%之內。

|

| ▲圖3 Rebalance達成資料分散。(圖片來源:EMC) |

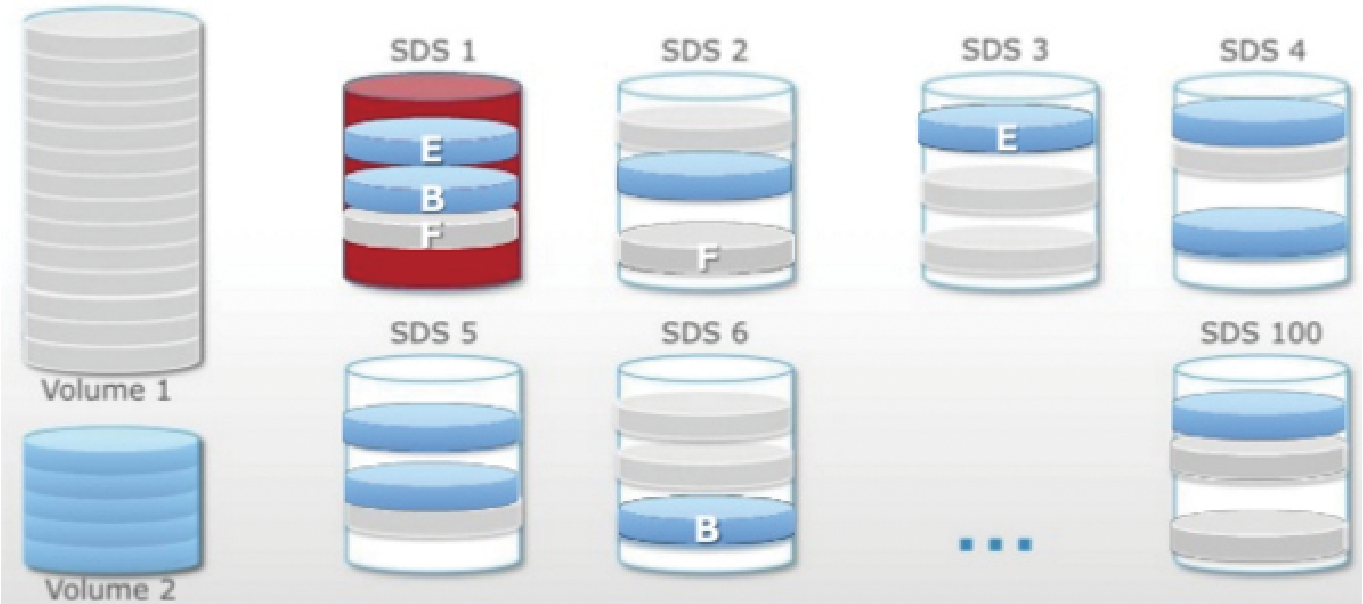

啟用Rebuild的情形有以下情況,例如SDS系統毀損或是硬體損壞(包括Server、Hot Drive、SSD),這意謂著ScaleIO環境中任一個節點出現問題時,系統要確保Data Protection維持資料Two-copy,因此會將故障節點內的資料全部複製一份至正常的儲存空間,如圖4所示。

|

| ▲圖4 Two-copy機制示意圖。(圖片來源:EMC) |

圖4解釋了Two-copy,邏輯空間Volume 1、Volume 2實際存放在100個節點內,從SDS 1至SDS 100。仔細看SDS 1的資料E、B、F,也存放在SDS 2、SDS 3、SDS 6的空間內,這就是ScaleIO資料保護。

此外,當SDS 1發生資料損壞時,存在SDS 2、SDS 3及SDS 6內的這些E、B、F資料,則會經過Mesh Mirroring演算複製到其他SDS空間內部,並維持兩份資料在系統中。

Elasticity(Add/Remove server & capacity on-demand)

彈性(Elasticity)也是SDS重要一項特性,打破傳統Storage的框架,可以選擇任何支援x86 Server與多樣的儲存媒體,讓公司購買或維護Storage Array不再受限於固定品牌或特定的硬碟型態。

ScaleIO Self-healing能協助完成維護的工作,可以動態地調整系統,不論新增/?移除Server或任何Drive,Rebuild及Rebalance都能夠背景處理,讓服務不中斷。